Original in Italian; automatic translation into English available here .

Ciao,

sono Stefano Gatti e questo è il settantanovesimo numero della newsletter LaCulturaDelDato: dati & algoritmi attraverso i nostri 5 sensi. Le regole che ci siamo dati per questo viaggio le puoi trovare qui.

Ecco i cinque spunti del settantanovesimo numero:

👀 Data Science. Master of Compression: Unpacking Paolo Ferragina's Insights on Data Algorithms

Presentati:

Paolo Ferragina. Sono un emigrante della conoscenza da più di 35 anni, avendo lasciato la mia città natale, Catanzaro, per studiare a Pisa nel glorioso corso di laurea in Scienze dell’Informazione (quale nome visionario!) e poi svolgere lì un dottorato in Informatica (sotto la supervisione di Fabrizio Luccio), e successivamente un post-doc presso il Max-Planck Institut fur Informatik (sotto la supervisione di Kurt Mehlhorn). Fabrizio e Kurt sono state due figure molto importanti per la mia formazione di ricercatore e non solo. Successivamente ho fatto ritorno a Pisa dove ho sviluppato la mia carriera accademica, ma con numerose esperienze di ricerca, spesso internazionali, con varie aziende (Google, Yahoo, Bloomberg, AT&T, ST microelectronics, Tiscali, Cerved, SpazioDati, Sadas, ...) e centri di ricerca (Harvard/MGH, NYU/Courant, North Texas,…). Ho anche ricoperto negli ultimi anni ruoli di governo dell’Ateneo pisano, quali Prorettore alla Ricerca Applicata e Innovazione (2010-2016) e Prorettore all’Informatica (2009-2012). Attualmente sono Professore Ordinario di Algoritmi presso il Dipartimento di Informatica dell’Università di Pisa.

Il mio ruolo tra 10 anni sarà ... (continua la frase come fossi GPT-10)

di formatore di nuove generazioni di ricercatori, e spero di innovatore nell’ambito ICT con particolare riferimento al progetto di algoritmi per la compressione e la ricerca su grandi quantità di dati. Dati sia in forma di collezioni testuali oppure, come accadrà sempre più spesso, di grafi etichettati con testo e numeri: Knowledge Graph, Deep Neural Networks o rappresentazioni ottenute con l’IA generativa. Spero anche di poter vedere in Italia un sempre maggiore “legame per l’innovazione” tra accademia e industria. La ricerca e la formazione italiana sono eccellenti e dunque molto saccheggiate dalle multinazionali straniere. Per cui, accanto alla ben celebrata “fuga dei cervelli” occorrerebbe parlare anche della “fuga delle idee”, e quindi dell’innovazione e della competitività delle nostre aziende.

Quale è la sfida più importante che il mondo dei dati e algoritmi ha di fronte a sé oggi?

Da algoritmista non posso non considerare le sfide legate all’IA, e quindi alla commistione sempre più efficiente ed efficace delle nuove tecnologie a essa collegate con le soluzioni “classiche” del mondo algoritmico. E questa “commistione” si sviluppa in entrambi i sensi: da una parte si parla sempre più spesso di “learned algorithms and data structures” ove elementi di machine learning pervadono il progetto di nuovi algoritmi e strutture dati più efficienti in tempo e spazio, grazie allo sfruttamento di pattern e ripetitività nei dati. D’altra parte, algoritmi e strutture dati vengono e saranno sempre più utilizzati nell’implementazione di Transformer (p.e., Reformer) o Vector DB, mediante l’uso di tecniche avanzate di compressione, locality sensitive hashing o approximate nearest neighbors, al fine di ottenere miglioramenti in tempo e spazio sulle loro prestazioni attuali.

Segnalaci il progetto o la risorsa nel mondo dei dati di cui non potresti fare a meno …Da ricercatore non posso non indicare tutte le riviste e le conferenze del settore: sono la principale fonte di ispirazione non solo per gli accademici ma per chiunque voglia fare innovazione. Temo per il preziosissimo arXiv che potrebbe subire nel prossimo futuro un bombing di testi generati dall’IA e quindi del tutto incontrollati e incontrollabili nei contenuti.

Mi sento anche di menzionare un progetto al quale sono particolarmente legato e che credo possa giocare un ruolo rilevante nel prossimo futuro: il Software Heritage Archive. Si tratta di un'ambiziosa iniziativa lanciata nel 2015 dall'INRIA – l'istituto nazionale francese di ricerca per le scienze e le tecnologie digitali – in accordo con l'UNESCO e che ha riunito nel tempo un gruppo di prestigiosi sostenitori e sponsor tra cui, tra gli altri, Microsoft, Intel, Google, VMWare, GitHub, Qwant, Nokia Bell Labs, e in Italia anche l’Università di Pisa. Il suo obiettivo principale è raccogliere, preservare e condividere tutto il software pubblicamente disponibile sotto forma di codice sorgente: una parte preziosa del nostro patrimonio culturale poiché incarna la nostra conoscenza tecnica e scientifica, oggi il fulcro della maggior parte dei progressi tecnologici. L'archivio SHA è un'infrastruttura rivoluzionaria che memorizza tutta la storia dello sviluppo del software in un gigantesco grafo (etichettato, appunto), con oltre 15 miliardi di file sorgente e oltre 3 miliardi di commit provenienti da oltre 230 milioni di progetti, per oltre un petabyte di dati. Con il mio gruppo di ricerca stiamo contribuendo a comprimere e cercare efficientemente ed efficacemente in questa grande messe di dati/informazioni, con applicazioni che vanno dalla generazione del codice (simile a Codex o Copilot), alla sua tracciabilità e sicurezza, fino all’individuazione del plagio. Visto il “modo” con cui il software di oggi, e sempre più di domani, verrà “generato” questo repository pubblico con tutte le funzionalità descritte sarà una preziosa risorsa da usare, preservare e condividere.

👂🏾Organizzazione e cultura dei dati e algoritmi nelle organizzazioni. From Data Governance to Innovator: The Dynamic Journey of CDOs

“Via via che le aziende iniziano ad adattare le strategie data-first, il ruolo del chief data officer sta diventando sempre più importante, soprattutto perché le imprese cercano di capitalizzare i dati per ottenere un vantaggio competitivo. Secondo le cifre di IDC, da un ruolo che, storicamente, era incentrato soprattutto sulla data governance e sulla conformità dei dati, la portata delle responsabilità dei CDO è cresciuta, fino a occupare una posizione di leadership aziendale strategica. Stando all’indagine, l’80% dei principali KPI su cui i CDO dichiarano di concentrarsi è orientato al business. I principali cinque includono l’efficienza operativa, la privacy e la protezione dei dati, la produttività e la capacità, l’innovazione e i ricavi, la soddisfazione e il successo dei clienti. L’87% dei CXO ha dichiarato che “far diventare l’azienda più intelligente è la loro priorità principale, da raggiungere entro il 2025”, con il 52% dei Chief Data Officer che, oggi, riferisce a un leader aziendale.”

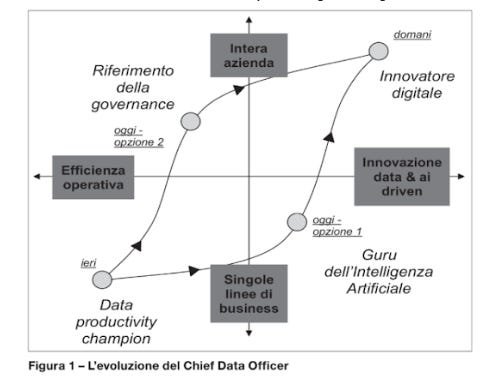

Questi dati provengono da un intrigante articolo di CIO.com che esplora l'evoluzione del ruolo del Chief Data Officer. Alberto Danese ed io avevamo già osservato questa tendenza quasi due anni fa nel nostro libro "La Cultura del Dato". Avevamo ipotizzato un cambiamento che avevamo scherzosamente denominato "ciclo di isteresi del CDO". Immaginavamo infatti che il futuro del CDO fosse quello di un innovatore digitale. Per chi è curioso e non ha ancora letto il libro, riporto la figura di seguito.

Riguardo all'articolo che ti suggerisco di approfondire oggi, continua esplorando le doti principali del data-expert che aspira al ruolo di CDO. Viene descritto infatti quale dovrebbe essere un curriculum vincente, evidenziando cinque caratteristiche fondamentali. Leggile tutte attentamente. Tuttavia, se dovessi scegliere le due più rilevanti per chi aspira a un ruolo simile in Europa occidentale, sottolineerei la capacità e l’esperienza nella trasformazione dell'intera azienda e di mostrare evidenza delle proprie soft skills. Queste sono le competenze che fanno la differenza, sia in fase di selezione sia per avere successo nel ruolo.

🖐️Tecnologia (data engineering). From Moore’s Predictions to AI’s Evolution: A Deep Dive into the Future of Tech

“Le leggi di scalabilità dell'intelligenza artificiale potrebbero rappresentare la più grande scoperta nell'informatica dall'introduzione della legge di Moore.” è così che comincia l’approfondimento che ti suggerisco oggi per comprendere l’evoluzione delle prestazioni dei Large Language Models, pilastri dell’intelligenza artificiale generativa. La legge di Moore, che anticipava un raddoppio della potenza dei microprocessori ogni 18 mesi, ha descritto fedelmente l'evoluzione delle capacità computazionali dagli anni ‘70 fino alla fine degli anni ‘20 del nuovo millennio. L'immagine che ti mostro di seguito, estratta da un paper di OpenAI del 2020, potrebbe delineare un percorso analogo per l’intelligenza artificiale.

Come viene detto nel paper: “Le prestazioni della modellazione linguistica migliorano con l'aumento delle dimensioni del modello, dei dataset e della quantità di calcolo utilizzata per l'addestramento. Per ottenere il massimo delle prestazioni, tutti e tre i fattori devono essere scalati simultaneamente. Ogni fattore ha una relazione di tipo power-law con le prestazioni, a meno che non sia limitato dagli altri due. Le prestazioni dipendono principalmente dalla scala, composta da tre fattori: il numero di parametri del modello N (esclusi gli embeddings), la dimensione del dataset D e la quantità di calcolo C impiegata nell'addestramento”. Finora in maniera più empirica rispetto alla legge di Moore (più facile da misurare), sembra che l’evoluzione delle performance dei modelli stia evolvendo proprio in questo modo. Questo non significa che, per compiti specifici, alcune tecniche come il fine-tuning non possano garantire risultati eccellenti senza incrementare i tre parametri. Ma per modelli più generalisti, come quello di ChatGPT, la AI Scaling Law potrebbe essere fondamentale per prevedere le future performance e determinare chi sarà in grado di raggiungerle. Se i dataset rappresentano un vincolo significativo, il numero di parametri e la capacità computazionale potrebbero ridurre notevolmente i concorrenti in questa corsa. Ed è fondamentale essere preparati, sia dal punto di vista economico che regolamentare.

👃Investimenti in ambito dati e algoritmi. How Generative AI is Changing the Game: Investing Tips from Deepwater’s Co-founder

“I migliori investitori del prossimo decennio non investiranno solo nell'intelligenza artificiale. Utilizzeranno l'intelligenza artificiale per potenziare la ricerca e stimolare la creatività negli investimenti…” Questo è l'inizio dell'approfondimento che ti suggerisco oggi in questa sezione della newsletter. È stato scritto da Doug Clinton, Co-founder e partner di Deepwater Asset Management, che investe in aziende innovative, sia pubbliche che private. Doug, nel suo post, evidenzia le tre aree principali in cui il nuovo trend di generative AI può essere utile a chi opera nel settore degli investimenti. In ordine di attuale applicabilità:

1. La sintesi delle informazioni: l'IA può essere impiegata per riassumere articoli, documenti ufficiali e altre fonti digitali, accelerando così la comprensione di un investimento.

2. La generazione di idee: con l'IA, è possibile identificare nuove aziende, tendenze in crescita e comportamenti dei consumatori.

3. Stock picking: l'IA può aiutarti a selezionare le aziende migliori in cui investire.

Come Doug ha sottolineato e come posso confermarti dalla mia esperienza, per i due ultimi obiettivi, Bard è più efficiente. Ciò perché sia ChatGpt che Claude2 (di Antropic) non possono reperire informazioni real-time dal web, il che rappresenta un notevole limite attuale per queste attività.

L'articolo propone anche esempi concreti e video per chi desidera approfondire ulteriormente. Se ti interessa il binomio "AI e investimenti", ti consiglio di seguire Doug Clinton. Egli approfondisce spesso le dinamiche di investimento nel nostro settore, presentando e condividendo informazioni su due indici specifici da lui creati: AI Average Index (AIAI) e AI Hardware Index (AIHI), dei quali puoi monitorare performance e composizione.

Se invece sei curioso di conoscere le aziende leader nel panorama globale degli investimenti relativi agli LLM, sia nel settore business che consumer, Strategy Deck ha pubblicato un articolo che offre una panoramica dettagliata e tabelle che riassumono le caratteristiche di ogni modello.

Queste sono informazioni preziose, soprattutto considerando che in Italia sembra si stia cominciando a riflettere su investimenti significativi in questo ambito!

👅Etica & regolamentazione & impatto sulla società. Facing the AI Wave: From Public Concerns to Google's Vision

Di fronte al futuro, ognuno di noi esprime un’opinione molto diversa, a seconda dei momenti della vita. Queste opinioni sono spesso il frutto delle informazioni che riceviamo dall'esterno su argomenti di grande dibattito. Il clima, l'immigrazione, episodi di violenza, e l'inflazione sono alcuni temi che, al momento, influenzano fortemente la nostra percezione del futuro. Nell'ultimo anno, l'intelligenza artificiale sta guadagnando sempre più "momentum" come argomento di rilevanza per il nostro futuro, sia professionale che personale. A tal proposito, ti consiglio di leggere questo articolo di The Verge. Attraverso un'indagine su 2000 adulti americani rappresentativi dell'intera popolazione, l'articolo cerca di illustrare l’impatto dell'intelligenza artificiale sulla nostra percezione del futuro. Benché questa indagine non pretenda di prevedere il futuro, è fondamentale considerare che tanto la regolamentazione quanto la politica, nella liquidità moderna, saranno sempre più influenzate dalla percezione collettiva. Data l'attenzione attuale e la rappresentazione non sempre accurata della situazione tecnologica da parte dei media, non mi sorprende che il 62% della popolazione sia preoccupato dell'effetto dell'intelligenza artificiale sul proprio futuro lavorativo e personale.

Nell'articolo troverai altre informazioni interessanti. The Verge, come spesso accade, combina una grafica accattivante con contenuti di qualità.

Preoccupazione sul proprio futuro relativamente allo sviluppo recente dell’intelligenza artificiale che è presente paradossalmente anche in Google che, a mio parere, non è riuscita ancora a immaginare come, nel breve periodo, possa coniugare la sua eccellenza in questo ambito con una sostenibilità economica ancora oggi fortemente basata sulla pubblicità digitale.

Per comprendere meglio il loro punto di vista e le loro iniziative, ti suggerisco questi due approfondimenti. Essi presentano la visione di Google sul futuro della ricerca online, introducendo concetti come la ricerca multimodale e la "search generative experience" (SGE). Quest'ultima modalità, che potrebbe trasformare l'interazione con il vasto corpus di conoscenza di Google, passando da una ricerca diretta a una più dialogica (simile alle chat GPT), non sembra facilmente sostenibile dal punto di vista economico. Tuttavia mi aspetto cigni neri da questo punto di vista da loro o da altri …

Se hai ulteriori suggerimenti e riflessioni sui temi di questo numero o per migliorare questa newsletter scrivimi (st.gatti@gmail.com) o commenta su substack.

Se ti è piaciuta e non sei ancora iscritto lascia la tua mail qui sotto e aiutami a diffonderla!

Alla prossima!