For my English speaking friends, click here for the translated version

Ciao,

sono Stefano Gatti e questo è il centotreesimo numero della newsletter LaCulturaDelDato: dati & algoritmi attraverso i nostri 5 sensi. Le regole che ci siamo dati per questo viaggio le puoi trovare qui.

Ecco i cinque spunti del centotreesimo numero:

👅Etica & regolamentazione & impatto sulla società. Città in Movimento: il Complexity Science Hub di Vienna e Tomas Pueyo

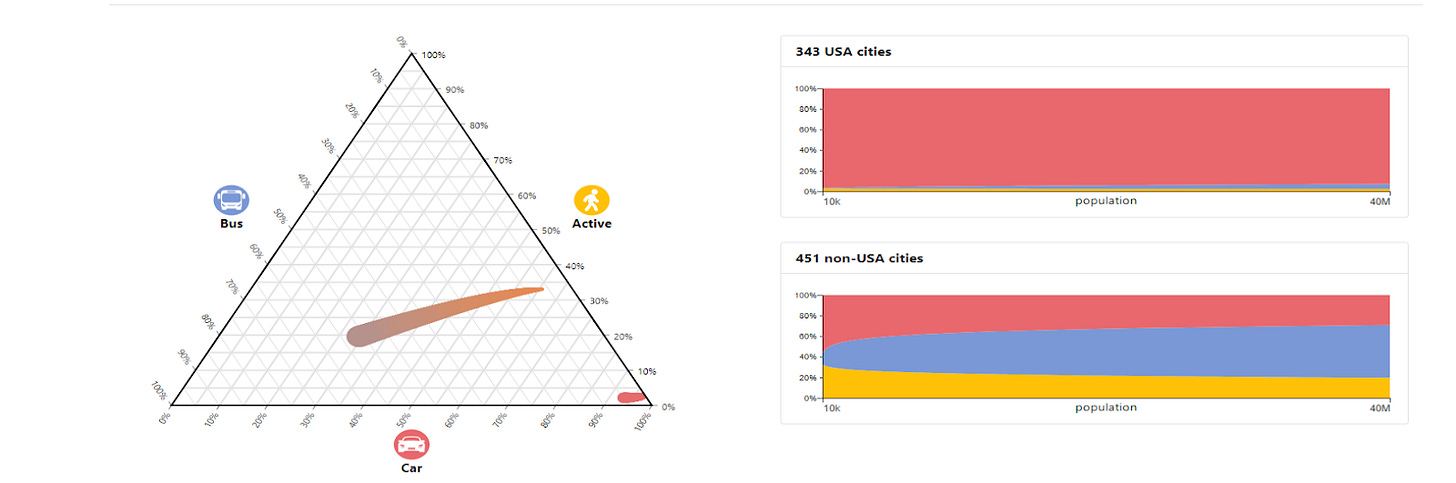

“Per quantificare le diverse tipologie di mobilità urbana, abbiamo misurato il numero di chilometri percorsi utilizzando varie modalità di trasporto in una città, aggregando mobilità attiva (come camminare, andare in bicicletta, usare il monopattino, etc.), trasporto pubblico e automobili. I nostri risultati indicano che, nonostante il trasporto pubblico giochi un ruolo cruciale nelle grandi città, questo non basta a ridurre significativamente la distanza percorsa in auto dagli utenti, né tantomeno le loro emissioni. Grazie ai dati forniti dal modello per 794 città in oltre 61 paesi, le visualizzazioni che seguono permettono di confrontare la percentuale di spostamenti verso il lavoro in diversi paesi, regioni, fasce di reddito e dimensioni della popolazione.” Questo progetto affascinante del Complexity Science Hub di Vienna, che ha una solida esperienza nell'analizzare vaste moli di dati, offre una panoramica dettagliata su come le persone si spostano all'interno delle città in tutto il mondo. È possibile confrontare le 794 città mondiali, incluse 23 italiane, analizzare le differenze tra singole nazioni o esplorare i pattern di mobilità nelle 7 aree in cui hanno suddiviso il mondo (Europa, Nord America, Sud Asiatico, America Latina, Est Asia e Pacifico, Africa Sub Sahariana, Medio Oriente e Nord Africa). Personalmente, ho scoperto differenze molto più marcate di quanto immaginassi. A titolo di esempio, il confronto tra le città americane e il resto del mondo è sorprendente!

Ti invito a prenderti il tempo necessario per esplorare le splendide dashboard realizzate, riflettendo sulle differenze di mobilità anche solo nelle città del nostro paese incluse nello studio. La mobilità è un aspetto fondamentale non solo per la sostenibilità ambientale, ma anche per l'evoluzione futura delle nostre città. È stato così in passato e lo sarà ancor di più in futuro. Tomas Pueyo, il pensatore poliedrico famoso per i suoi contributi significativi durante la pandemia di COVID-19, ha riflettuto profondamente su questo tema nella sua newsletter Uncharted Territories, alla quale sono abbonato. Ha intrapreso un'analisi dettagliata, partendo dalle ragioni storiche alla base della formazione delle città, fino ad arrivare a considerazioni sul presente e sul possibile futuro urbano, con un focus particolare sulla mobilità. Se sei curioso, ecco il link all'inizio di questo interessante viaggio, accessibile a tutti. Per continuare la lettura, è necessario abbonarsi, ma ti assicuro che ne vale la pena!

🖐️Tecnologia (data engineering). Privacy e Sicurezza: La Strategia di Alec Alpha nell'Intelligenza Artificiale

Aleph Alpha, insieme alla francese Mistral, di cui ti ho già parlato, rappresenta uno dei migliori progetti/start-up europei nell'ambito della generative AI e dei Large Language Models (LLM). A differenza di Mistral, che realizza modelli Open Source per una rapida distribuzione e applicazione, Aleph Alpha segue una filosofia e missione diametralmente opposta. L'obiettivo dell'azienda, con la sua famiglia di modelli denominata Luminous, si basa sul principio "Sovereignty first", dando priorità alla privacy, sicurezza, trasparenza e alla proprietà dei dati per i suoi clienti, principalmente enti governativi e aziende private. Il modello Luminous pone grande enfasi sulla spiegabilità, cioè come si è arrivati a un risultato sulla base dei dati di input. Nonostante i suoi modelli non siano Open Source, Alec Alpha è profondamente impegnata nel rispetto del GDPR e dell’AI Act, mantenendo collaborazioni attive con prestigiosi centri di ricerca e università europee. Si distingue anche per il suo profilo di finanziamento fortemente europeo, con un nucleo tedesco di spicco, includendo tra i suoi investitori principali il gruppo Lidl (Schwarz Group), Bosch Ventures e l'Innovation Park Artificial Intelligence (Ipai) nel sud-ovest della Germania. Per approfondire Alec Alpha, ecco un articolo che ne esplora la storia, la filosofia di sviluppo e il modello di business. E se vuoi sperimentare direttamente, ti consiglio il loro playground: un po’ nerd e spartano, ma estremamente efficace e istruttivo per comprendere i meccanismi di funzionamento e il mercato di riferimento.

👂🏾Organizzazione e cultura dei dati e algoritmi nelle organizzazioni. Memoria AI: Il Futuro di ChatGPT tra Entusiasmo e Privacy

Una delle esperienze più frustranti nell'utilizzo degli strumenti di intelligenza artificiale generativa, inclusi quelli avanzati come Chat-GPT4, è la necessità di ripetere come eseguire un compito quando questo diventa “abbastanza” ripetitivo. Vorremmo che questi strumenti apprendessero le specificità dell'interazione senza doverle esplicitare ogni volta. OpenAI ha risposto a questa esigenza introducendo prima le custom instructions e poi i ChatGPTs, richiedendo comunque uno sforzo iniziale da parte dell'utente per definire i comportamenti desiderati. Anche i plugin, nonostante siano numerosi (ne ho contati 774 nella mia istanza di Chat GTP-4), non hanno ottenuto il successo sperato, limitandosi spesso a una mossa di marketing da parte delle aziende. Di recente, OpenAI ha annunciato per Chat-GPT4 una nuova funzionalità che permetterà di "ricordare le nostre conversazioni e preferenze", o per dirla in maniera più coinvolgente, come scrive TheVerge qui, “ChatGPT is getting ‘memory’ to remember who you are and what you like”. Se sei curioso di sapere come il tutto funzionerà ti consiglio di andare direttamente alla descrizione che ne fa OpenAI. Sono molto entusiasta di questa novità, poiché potrebbe migliorare l'esperienza utente più di un avanzamento tecnologico dell'LLM stesso, soprattutto in ambito aziendale.

D'altra parte, la parte di me più attenta all’etica, alla privacy e all’uso dei dati personali è francamente molto più preoccupata per la concentrazione di informazioni che questi strumenti avranno in futuro. Se già oggi, come scrive questo datato ma ancora ottimo articolo del Post, “sembra che gli smartphone ci ascoltino” quali saranno gli scenari futuri quando il nostro assistente saprà molto di più di quello che già oggi conosce Google attraverso le nostre ricerche?

La funzionalità di "memoria" potrebbe offrire grandi vantaggi nell'automatizzazione di processi aziendali non standard, ma è essenziale valutare attentamente i pro e i contro su base personale. La storia della ricerca e dei cookie dimostra che è necessaria una regolamentazione rigorosa e un controllo attivo su chi detiene queste informazioni.

👀 Data Science. È davvero TimeGPT la Chiave per il Futuro delle Serie Temporali?

“TimeGPT è un modello per serie temporali basato su tecnologia Transformer con meccanismi di auto-attenzione (quella che usa anche ChatGPT n.d.r.) … . L'intuizione di base è che i meccanismi basati sull'attenzione siano in grado di catturare la varietà degli eventi passati e di estrapolare correttamente le potenziali distribuzioni future … Va notato che TimeGPT non si basa su un modello linguistico di grandi dimensioni (LLM) esistente. Sebbene TimeGPT segua lo stesso principio di addestramento di un LLM su un vasto insieme di dati, la sua architettura è specializzata nella gestione di dati di serie temporali e addestrata per ridurre al minimo l'errore di previsione.”

Questo approfondimento è particolarmente consigliato se lavori con dati di serie temporali o se sei interessato a monitorare le novità nell'ambito dell'intelligenza artificiale generativa in settori innovativi. Il progetto è di una start-up Nixtla che ha già ricevuto nel 2023 un round seed di circa 6 milioni di dollari. Dalla teoria alla pratica, ecco cosa puoi esplorare:

- Il paper originale del progetto;

- Una descrizione tecnica dettagliata;

- Un'introduzione pratica alla libreria Python per testare il modello.

Dai primi test, TimeGPT non ha ancora raggiunto le prestazioni dei migliori modelli tradizionali per serie temporali, ma mostra comunque risultati comparabili. Persistono alcune incertezze riguardo la capacità del modello di spiegare i propri risultati, un aspetto cruciale in alcuni contesti regolamentati.

Se desideri esplorare il mondo delle serie temporali senza partire dalle reti neurali, ecco due risorse gratuite molto interessanti:

- Una guida creata da Rob J Hyndman e George Athanasopoulos, due dei più importanti esperti mondiali, accessibile ai principianti ma ricca di dettagli tecnici avanzati;

- Un articolo dettagliato per data scientists che illustra gli errori comuni nel lavoro con serie temporali e offre consigli pratici per evitarli.

👃Investimenti in ambito dati e algoritmi. L'Ascesa di Nvidia e il Futuro Robotico: Un'Intelligenza Artificiale Rivoluzionaria

Il 14 Febbraio 2024, Nvidia ha superato anche Alphabet in termini di capitalizzazione di mercato, posizionandosi come la terza azienda americana, subito dopo Apple e Microsoft. Questo traguardo sottolinea ancora una volta la correttezza dell'inserimento di Nvidia tra le big tech americane. Gli ingenti investimenti di Nvidia nel panorama dell'intelligenza artificiale, come menzionato nel numero 101 della nostra newsletter, la pongono indiscutibilmente tra le aziende da tenere d'occhio in futuro. Ancor più interessante, ed è l’approfondimento di oggi, sono i segnali evidenti della capacità dei Large Language Models (LLM) di accelerare un settore, quello della robotica, che finora ha registrato un'evoluzione più lenta del previsto. Ti invito a leggere la parte gratuita di questo post, che illustra evoluzioni promettenti nel campo robotico, attraverso un progetto sviluppato da Google DeepMind in collaborazione con l'Università di Stanford. Il progetto, denominato Aloha, dimostra gli attuali progressi con hardware open source e relativamente economico (circa 32.000 dollari). Gli LLM, utilizzati nell'intelligenza artificiale generativa, sembrano poter accelerare significativamente il processo di apprendimento dei robot, superando la limitazione a compiti specifici. Se gli LLM saranno usati su larga scala anche nel settore della robotica, il valore strategico di Nvidia potrebbe raggiungere vette ancor più elevate, rendendo il piano di investimento di 7 trilioni di dollari di Sam Altman per la produzione di chip per l'AI generativa meno folle di quanto possa sembrare 🙂

Se hai ulteriori suggerimenti e riflessioni sui temi di questo numero o per migliorare questa newsletter scrivimi (st.gatti@gmail.com) o commenta su substack.

Se ti è piaciuta e non sei ancora iscritto lascia la tua mail qui sotto e aiutami a diffonderla!

Alla prossima!