For my English speaking friends, click here for the translated version

Ciao,

sono Stefano Gatti e questo è il centotrentaseiesimo numero della newsletter LaCulturaDelDato: dati & algoritmi attraverso i nostri 5 sensi. Le regole che ci siamo dati per questo viaggio le puoi trovare qui.

Ecco i cinque spunti del centotrentaseiesimo numero:

👀 Data Science. Dai misteri del cosmo al DNA (e non solo …): Andrea Palladino ci racconta il suo viaggio.

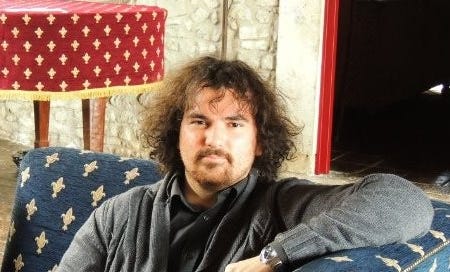

Presentati:

Andrea Palladino. Sono un fisico, con Dottorato in Astrofisica delle particelle. Dopo il PhD al Gran Sasso Science Institute (L’Aquila) e il Postdoc al Deutsches-Elektronen-Synchrotron di Zeuthen (Germania), sono passato al mondo della Data Science, lavorando in una startup di Berlino chiamata Apheris.

In Apheris mi sono occupato in particolare di reti neurali e di federated learning, una forma di machine learning collaborativo che punta a preservare la privacy dei dati.

Oggi lavoro alla GlaxoSmithKline (GSK) come Senior Data Scientist e mi occupo di Natural Language Processing applicato a sequenze di DNA e di algoritmi di supervised e unsupervised learning applicati a dati umani.

Mi piace parlare di scienza e di intelligenza artificiale e svolgo attività di divulgazione tramite il mio profilo Linkedin.

Il mio ruolo tra 10 anni sarà ... (continua la frase come fossi GPT-10)

Questa è probabilmente la domanda più difficile che mi potessi fare.

Fino ai miei 20 anni ero convinto che avrei fatto il pianista nella mia vita (sono diplomato in pianoforte al conservatorio). Poi tra PhD e Postdoc ho svolto ricerca nell’ambito dell’astrofisica per circa 6 anni, pubblicando oltre 30 articoli.

Dal 2020 mi occupo di analisi dati e di modelli di machine learning, un mondo che permette di lavorare in settori molto diversi fra loro.

Dunque le mie capacità di predire il mio futuro sono molto scarse! Ma ci sono due campi che mi interessano e nei quali non ho ancora mai lavorato: la Formula 1 e l’ambito finanziario. Chissà, magari fra 10 anni sarò un Head of Data Science in uno di questi settori!

Quale è la sfida più importante che il mondo dei dati e algoritmi ha di fronte a sé oggi?

Quando una tecnologia diventa di moda e alla portata di tutti, c’è sempre il rischio che venga usata nel modo errato. Oggi siamo invasi dagli algoritmi di AI generativa. Ogni settimana viene annunciato un nuovo modello che supera il precedente in qualche compito specifico.

Il problema è che però questi modelli richiedono un’enorme quantità di dati per essere allenati e alcuni di essi continuano ad essere affetti da allucinazioni nelle risposte.

La sfida più grande a mio avviso è riuscire a procurarsi dati di qualità, mentre la mia paura principale è che gli algoritmi futuri corrano il rischio di venire parzialmente allenati con le allucinazioni create dai loro predecessori.

È un rischio concreto, sul quale bisogna cominciare a riflettere già da oggi.

Segnalaci il progetto o la risorsa nel mondo dei dati di cui non potresti fare a meno …

Se mi avessi fatto questa domanda un paio d’anni fa, avrei risposto senza ombra di dubbio Stack Overflow. È una miniera di informazioni per tutto ciò che concerne la programmazione e l’implementazione di algoritmi di machine learning.

Oggi però, non posso fare a meno di menzionare anche i Large Language Mode. In particolare io uso quotidianamente Chat-GPT e Copilot. È innegabile che questi strumenti abbiano contributo a facilitare la vita, in particolare nello svolgimento di attività ripetitive e noiose.

Trovo molto utile anche Google Colab, che permette di creare dei Notebook in Python direttamente sul cloud, dando la possibilità di usufruire gratuitamente delle GPU.

🚀 Questa puntata è sponsorizzata da Ellycode

Lo sponsor di questa puntata è la start-up Ellycode e, soprattutto, la sua piattaforma Elly, perché mi piacciono le cose concrete e facilmente utilizzabili.

Elly è una piattaforma di Business Intelligence potenziata dall’intelligenza artificiale, ideata e realizzata per essere accessibile a tutti. La missione è trasformare i dati aziendali in informazioni strategiche, semplificando i processi decisionali e aiutando tutte le aziende, non solo le più grandi, a diventare realmente data-driven in pochissimo tempo.

Uno dei principali punti di forza di Elly è la semplicità nell'integrazione dei dati, grazie a connettori già pronti per i principali software commerciali. La piattaforma consente di importare dati da file CSV ed Excel, oltre a estrarre informazioni direttamente da diversi gestionali presenti nel cloud. In questo modo, Elly riduce drasticamente il tempo e le risorse necessarie per implementare una soluzione di Business Intelligence.

Durante l'evento verranno presentate le novità della nuova versione di Elly, e avrai l'opportunità di conoscere il team, pronto a rispondere a tutte le tue domande.

👃Investimenti in ambito dati e algoritmi. Generative AI: tra sostenibilità e Crisi imminente …

L'argomento di cui ti parlo in questa sezione è un tema sollevato da diversi lettori della newsletter: la sostenibilità economica di tutto il settore della generative AI. Questo aspetto è cruciale anche per gli investimenti nelle start-up, che stanno ricevendo finanziamenti importanti e basano una parte rilevante dei loro prodotti e servizi proprio sugli LLM.

In particolare, i due approfondimenti che ti suggerisco di leggere mi sono stati consigliati da due lettori e amici, con cui spesso discuto di eco-sostenibilità (leggi il prefisso leggi l’eco in senso soprattutto economico n.d.r.) nel business. È un tema che mi appassiona, come forse hai intuito, non solo relativamente alla generative AI, ma anche per esempio per tutto il settore dell’informazione, che fatica a trovare un suo modello di business dopo le disruption subite dal web 1.0 e 2.0.

Ma torniamo al tema della generative AI e alla sua sostenibilità nel medio periodo. Ti consiglio di iniziare da questo articolo, che fornisce un'ottima sintesi di come si compongono i ricavi dei due principali player indipendenti (o quasi) della generative AI, con una proiezione di tali ricavi nei prossimi anni.

C'è anche un'analisi, sebbene meno dettagliata, dei costi. Questa opacità (sui costi) è in parte dovuta alla relazione privilegiata che questi player hanno con i principali fornitori di infrastrutture cloud che sono in alcuni casi loro stessi investitori nelle aziende.

Dopo aver letto questo articolo, ti invito a passare al secondo, molto più provocatorio e in un certo senso catastrofico. Il titolo, "The Subprime AI Crisis", prevede una crisi imminente che coinvolgerebbe i principali player della generative AI, che andrebbe ad impattare anche su Big Tech e start-up del settore.

Prima di leggerlo, ti segnalo che Ed Zitron, l'autore, è una figura di spicco nel settore tecnologico e delle relazioni pubbliche. È noto per le sue opinioni critiche sull'industria tecnologica e i suoi protagonisti. Zitron è CEO di EZPR, un'agenzia di PR specializzata in aziende tecnologiche, e autore della popolare newsletter "Where's Your Ed At", da cui l’articolo è tratto.

Sebbene ci siano spunti interessanti nell'analisi di Zitron, ci sono alcuni aspetti che, a mio parere, non reggono:

1. Sottovaluta la tendenza “deflattiva della tecnologia”, ovvero che i servizi di generative AI, a parità di qualità, costano sempre meno.

2. Non esiste un effetto leva simile a quello della crisi dei subprime, e la crisi coinvolgerebbe capitali "di rischio", che sono meno centrali nel sistema economico globale.

3. I valori in gioco, anche in termini di perdite, sono ancora una parte molto ridotta dell’utile delle big tech, come puoi vedere dal primo articolo che ti ho suggerito.

Leggi i due articoli e, se vuoi condividere il tuo parere nei commenti o via email, sarò felice di sentire la tua opinione!

🖐️Tecnologia (data engineering). Attivare la Memoria su ChatGPT: vantaggi cognitivi e dubbi di sicurezza

Il 9 settembre, OpenAI ha reso disponibile anche in Europa la funzione “Memoria”, che crea gradualmente un profilo di informazioni relative all’utente che usa ChatGPT, personalizzandone l’esperienza. Avevo già avuto modo di vedere questa funzionalità in anteprima quando, a Marzo di quest'anno, ero stato presso OpenAI a San Francisco. Avevo il sospetto che, per via del GDPR, sarebbe stato difficile attivarla in Europa. Evidentemente mi sbagliavo. Probabilmente, ciò che ha reso possibile il lancio è la necessità della attivazione esplicita da parte dell'utente e il fatto che si offre all’utente la possibilità di cancellare le memorie in qualsiasi momento, totalmente o in parte.

Non ho letto molti commenti o prove su questa funzionalità, o almeno non tante quante mi sarei aspettato. Forse perché, partendo da zero (le memorie), l'effettivo impatto sull'esperienza utente si percepisce solo dopo qualche settimana o mese. Da utente affezionato di ChatGPT, sono entusiasta della nuova funzionalità, ma nutro alcune perplessità su come sia stata implementata, soprattutto per quanto riguarda la sicurezza.

Ecco perché oggi ti consiglio tre approfondimenti che affrontano proprio queste mie perplessità, così potrai utilizzare al meglio questa funzione, se lo desideri, o comunque comprendere appieno come funziona.

1. Come funziona davvero? La prima cosa da fare, come sempre, è capire come funziona. Niente è meglio che iniziare leggendo le istruzioni o, meglio ancora, le FAQ di chi ha sviluppato la funzione. Ti segnalo inoltre un dettaglio che ho testato personalmente e che non è del tutto chiaro: la memoria funziona anche in modalità implicita. ChatGPT aggiorna le informazioni in memoria anche senza una richiesta esplicita da parte tua. Se ci fai caso, quando lo fa, compare la scritta "memoria aggiornata" accanto al simbolo di OpenAI nella chat.

2. Il valore cognitivo della memoria. Leggi il pezzo di Nick Potckalitsky che spiega i vantaggi, per un sistema di intelligenza artificiale come ChatGPT, di avere una memoria a lungo termine. Potckalitsky spiega come questa funzione stia diventando, o diventerà con l'uso, una vera e propria funzione cognitiva, facendo anche riferimento alla teoria del sistema 1 e 2 di Daniel Kahneman. Se questo ti sembra troppo astratto, puoi leggere l'articolo di Daniel Nest, che offre consigli pratici su come utilizzare efficacemente questa funzione.

3. Sicurezza prima di tutto. Prima di attivare la funzione, non dimenticare di considerare gli aspetti legati alla sicurezza. Ti consiglio di leggere il post di Luca Sambucci, esperto di sicurezza informatica, che approfondisce proprio questo argomento. Nel suo post, Sambucci racconta anche come la funzione di memoria di ChatGPT sia stata hackerata a causa di una vulnerabilità presente in una delle sue interfacce.

👂🏾Organizzazione e cultura dei dati e algoritmi nelle organizzazioni. Decisioni difficili: meglio un compromesso o una scelta coraggiosa?

Quando si prendono decisioni in azienda, analizzare i dati è una pratica sempre più diffusa e sempre più efficace, anche se c'è ancora molto da migliorare, sia a livello di processo (come la disponibilità dei dati) che di cultura (nell'utilizzarli). Fino a quando non delegheremo queste scelte strategiche a un agente — probabilmente mai — dovremo comunque prendere delle decisioni, e spesso si tratta di scegliere tra due opzioni che sembrano essere mutuamente esclusive. Apparentemente.

L'articolo che ti consiglio oggi, sul tema del decision making, mi ha fatto riflettere molto. Ho trovato spunti davvero interessanti, accompagnati da esempi tutt'altro che banali.

Jason Cohen, di cui ti ho già proposto altri contributi in passato, sfida alcuni luoghi comuni in un post dal titolo (e sottotitolo) molto esplicativo:

Quando ci troviamo a dover scegliere tra due opzioni, il tentativo di mediare ("it’s a balance") è spesso molto forte, soprattutto nelle organizzazioni complesse, e sembra pagare di più nel breve termine. Tuttavia, a lungo termine, questa strategia spesso non si rivela vincente.

Prendere una decisione netta, scegliendo una sola opzione in modo chiaro, o provare a percorrere entrambe le strade che sembrano, solo in apparenza, mutuamente esclusive, può essere la scelta migliore. Tuttavia, queste decisioni comportano sfide complesse e possono risultare impopolari nel breve periodo.

Se leggi l’articolo, fammi sapere nei commenti cosa ne pensi. Nella mia esperienza lavorativa, spesso non trovare un compromesso a tutti i costi ha portato a risultati migliori nel lungo termine, anche se ha aumentato la complessità operativa, relazionale (con i team coinvolti) e decisionale nell'immediato.

E a proposito di possibile delega alla AI delle decisioni importanti (quelle che normalmente in aziende prende il CEO) può essere interessante leggere questo studio pubblicato dalla Harward Business Review. Ma non fermarti a leggere solo i risultati che sembrerebbero dare ragione all’AI rispetto ai migliori manager in carne e ossa. Leggi soprattutto la seconda parte dove si evidenzia quante limitazioni ha questo esperimento e quanto lontano sia dalle normali condizioni in cui si prendono decisioni 🙂.

👅Etica & regolamentazione & impatto sulla società. Data is Plural: la risorsa segreta dei data-lovers

Ci sono state altre 102 puntate della splendida newsletter di Jeremy Singer-Vine dopo la segnalazione, che era stata la più cliccata, che ti avevo fatto nel numero 15 di “La Cultura del Dato”. Data is Plural è una newsletter più longeva della nostra, ma un pizzico meno costante: ci sono state 121 puntate di “La Cultura del Dato” 🙂 da allora!. Come ti scrivevo quasi tre anni fa, Jeremy Singer-Vine è un giornalista (Wall Street Journal e BuzzFeed News, e da settembre 2024 Data Editor del New York Times), un programmatore, ma soprattutto un data-lover. Da anni propone utili e curiosi dataset aperti attraverso la sua newsletter Data is Plural, che è diventata molto cool tra i data scientist di tutto il mondo.

Gli argomenti trattati sono davvero i più disparati: si va dal dataset di tutti gli incidenti con armi da fuoco negli Stati Uniti dal 1970 ad oggi, al database di tutti i libri perfettamente annotati di Art Garfunkel, fino ai dati di tutti gli atleti che hanno vinto una medaglia olimpica nella storia. Vista la sua professione, i dati che propone sono prevalentemente legati all’attualità e a tematiche economiche. Ci sono due modi per sfruttare al meglio questa risorsa: seguirlo tutte le settimane, vedendo anche le considerazioni derivate, in tutto il mondo, dai dataset che propone, oppure navigare per parole chiave nel suo archivio quando ne hai bisogno. Una risorsa imperdibile per ogni data-lover!

📅 Nel Mio Calendario (passato, presente e futuro)

Una mia intervista uscita su Repubblica a commento di uno studio che parla del “model autophagy disorder (MAD) che, semplificato, coincide con l’idea che i modelli IA, con il tempo, tendano a collassare su loro stessi per mancanza di dati”. L’articolo lo ha scritto Giuditta Mosca, una giornalista molto preparata che è anche una lettrice di questa newsletter 😊.

Se volete sentire la chiacchierata che ho fatta con Santina Giannone in settimana sul tema comunicare (con) i dati la potete trovare su YouTube qui

Se hai ulteriori suggerimenti e riflessioni sui temi di questo numero o per migliorare questa newsletter scrivimi (st.gatti@gmail.com) o commenta su substack.

Se ti è piaciuta e non sei ancora iscritto lascia la tua mail qui sotto e aiutami a diffonderla!

Alla prossima!