For my English speaking friends, click here for the translated version

Ciao,

sono Stefano Gatti e questo è il centotrentasettesimo numero della newsletter LaCulturaDelDato: dati & algoritmi attraverso i nostri 5 sensi. Le regole che ci siamo dati per questo viaggio le puoi trovare qui.

Ecco i cinque spunti del centotrentasettesimo numero:

👃Investimenti in ambito dati e algoritmi. Il valore non scontato dei dati: perché non sono come il petrolio

"La determinazione del prezzo dei dati è spesso approssimativa e inesatta; i dataset possono essere gratuiti o valere milioni; pochissime persone sanno come prezzare un asset di dati o quali sono i criteri di calcolo. Questo saggio è un tentativo di cambiare questa situazione."

scrive con una frequenza molto bassa, ma quando lo fa, scrive (quasi) sempre dei capolavori o comunque riesce a condensare la sua esperienza a 360° nel mondo dei dati e degli algoritmi. Se vuoi saperne di più sulla sua esperienza, ti consiglio di andare qui. In breve, ha creato Quandl, diventata leader mondiale degli “alternative data” e poi venduta al Nasdaq, l'azienda che gestisce l'omonimo mercato borsistico. Ha lavorato anche come manager in hedge fund e oggi è principalmente un investitore.Anziché cercare di sintetizzare il saggio, il che sarebbe impossibile, ti condivido un estratto in cui spiega perché, almeno dal punto di vista del prezzo, il paragone dei dati con il petrolio non regge:

"I dati sono il nuovo petrolio, si dice; i dati sono il nuovo oro. Bene, allora: il petrolio costa ottanta dollari al barile e l'oro ventitré dollari l'oncia. Quanto costano i dati?

È una domanda senza senso.

I fattori che determinano il prezzo del petrolio possono essere complessi, ma esiste un consenso consolidato sui criteri di transazione: volume, luogo, qualità e data. Esistono borse che specificano le regole di consegna per i contratti di riferimento come WTI, Brent e Dubai. Quando si acquista un barile di greggio, si sa cosa si sta ricevendo.

I dati... non sono così. I dati sono intrinsecamente eterogenei. Il set di dati A e il set di dati B possono trovarsi entrambi su un disco da qualche parte, ma spesso non hanno assolutamente nulla in comune. Campi, schemi e specifiche diversi; temi, coperture e contenuti informativi diversi; consumatori, casi d'uso e valore diversi. Ogni barile di greggio WTI è identico; nessun set di dati è identico."

Se ti interessa il tema del valore economico dei dati, questo saggio è imperdibile e risuona con le mie esperienze, per quanto più limitate, che ho avuto in varie aziende, da entrambi i lati della domanda e dell’offerta di dati.

Nel saggio,

parla anche di come questa prospettiva sul valore dei dati stia cambiando con l’avvento della generative AI.Imperdibile!

PS: Come ti dicevo, Abraham scrive in maniera incisiva, ma raramente. Per questo uno degli aspetti più interessanti della traduzione inglese della Cultura del Dato è che siamo riusciti,

ed io, ad averlo come ospite per una chiacchierata nella postfazione del libro. Ed è stato molto bello.🖐️Tecnologia (data engineering). Full Homomorphic Encryption spiegata semplice: cosa potrà fare (e cosa ancora non può fare) per i tuoi dati

“Se hai sentito parlare di Full Homomorphic Encryption (FHE) e sei esperto di software, probabilmente hai sentito due cose: permette di eseguire programmi direttamente su dati criptati senza mai decriptarli; ed è ancora troppo lenta per essere realmente utile. Tuttavia, al di là di queste informazioni, non ci sono molte risorse che offrono una panoramica accessibile senza dover sfogliare un articolo di ricerca di 40 pagine …”

Per colmare questa lacuna e aiutarti a superare la semplice buzzword che spesso trovi nei report sulle tecnologie futuristiche, ti consiglio questo articolo di Jeremy Kun. Se vuoi avere una comprensione, anche solo di base, di questo strumento che potrebbe diventare (o meglio sarà) estremamente utile per chi lavora con dati, soprattutto quelli sensibili o di alto livello di confidenzialità, questo è il punto di partenza ideale.

Il post offre tre livelli di lettura. Anche se è più semplice di un paper, non aspettarti una lettura leggera! Ma puoi:

1. Fermarti (si fa per dire!) alla sezione "highest level view", che ti darà un'idea generale della tecnologia e dei suoi attuali limiti in termini di cosa si può fare e quanto lentamente lo si può fare: si parla di una riduzione delle performance di circa un milione di volte rispetto al lavoro sui dati non criptati anche su operazioni a bassa complessità.

2. Addentrarti nell'esempio, codice alla mano, di una semplice moltiplicazione in modalità FHE. È istruttivo e accessibile anche per chi non ne sa nulla.

3. Leggerlo tutto, se vuoi davvero comprendere lo stato dell'arte della tecnologia.

Jeremy Kun, attualmente staff software engineer in Google, sta lavorando proprio su progetti legati alla FHE. Con un background matematico, scrive molto bene all’intersezione tra matematica e sviluppo software e ha anche pubblicato un libro cult su questi temi.

Personalmente, nella mia precedente esperienza lavorativa, ho facilitato un progetto d’innovazione che mirava all’uso della multiparty computation in contesti business. Questa tecnologia condivide un obiettivo simile alla FHE, ma è più matura in termini di implementazione, anche se meno solida in termini di sicurezza e più limitata nei casi d’applicazione.

👂🏾Organizzazione e cultura dei dati e algoritmi nelle organizzazioni. Dal data stack alle persone: il segreto per un Dream Data Team vincente

Era stato il link più cliccato nel sedicesimo numero della newsletter e devo dire che, come quasi tutti i link più cliccati (bravi 👏), anche questo è invecchiato molto bene!

“Costruire un “dream data team” è molto di più che usare il giusto data stack”, scriveva Prukalpa Sankar, data lover e founder di Atlan. L’evoluzione della generative AI ha reso questo obiettivo ancora più importante (e difficile da raggiungere). Mettere al centro le persone, farle crescere e facilitare il loro lavoro è diventato ancora più complesso, ma anche più strategico. Partire dalla tecnologia, visti i suoi rapidi cambiamenti, è ancora più sbagliato (di tre anni fa). Avere il giusto mix di persone ti permette di superare eventuali errori o imperfezioni nelle scelte tecnologiche fatte.

Costruire un dream data team è un viaggio, e Prukalpa Sankar ci suggerisce, in questo articolo, il suo modo migliore di affrontarlo. Lo fa in maniera molto pratica, consigliando artefatti che hanno facilitato questo percorso. Gli artefatti, una delle componenti della definizione di cultura che più mi piace, sono fondamentali perché, come scrive Prukalpa, “… molte persone credono che la cultura "accada e basta". È una creatura mitica, ed è semplicemente quello che è… Non sono assolutamente d'accordo. La cultura non accade e basta. Potete lavorare per creare la cultura a cui aspirate convertendo i vostri valori in qualcosa di più tangibile. Noi lo abbiamo fatto attraverso...”.

Tutte parole che risuonano con quanto ho vissuto in vari percorsi di creazione o trasformazione di team dati. Ne abbiamo parlato anche nel nostro libro, insieme ad

, raccontando esperienze, errori e buone pratiche dei nostri viaggi. Diversi rispetto a quelli narrati da Prukalpa, ma con molti punti in comune.👀 Data Science. Generative AI per tutti: il progetto open-knowledge di Aishwarya per apprendere in modo progressivo e veloce

Quando trovo progetti open-knowledge come quello che ti propongo oggi, si rafforza ancora di più la mia convinzione che la risorsa più scarsa che abbiamo sia il tempo. Saperlo usare, il tempo, in maniera efficiente e sostenibile, anche dal punto di vista del benessere fisico e mentale, è una grossa sfida della modernità.

L'approfondimento che ti consiglio oggi nasce da Aishwarya Naresh Reganti, tech lead in Amazon AWS e visiting lecturer all’MIT. In estrema sintesi, Aishwarya, oltre ad essere un'ottima divulgatrice sui media, ha realizzato come progetto personale su GitHub il repository di informazione e formazione più ampio e denso sulla generative AI che abbia finora visto. Oltre ad essere davvero vasto, è anche ben strutturato, il che rende le informazioni facilmente accessibili.

Aishwarya non si limita a collezionare link ad altri progetti formativi (gratuiti) e ai migliori paper del mese, ma crea anche lei stessa artefatti formativi. In questo senso, menzione d’onore va al corso che ha realizzato ad inizio anno. Ti evidenzio qui sotto la mappa degli argomenti per darti un’idea di quanto vasti siano i domini esplorati.

Non devi necessariamente seguirlo tutto, ma puoi utilizzare le parti che ti servono in base agli argomenti che desideri approfondire in quel momento. Il tutto è affrontato in modo molto pratico e concreto, come evidenziato dal titolo: Applied LLMs Mastery.

Molti di voi mi hanno chiesto un elenco di risorse per imparare e comprendere la generative AI, e questo è quanto di più vicino a ciò che mi avete richiesto.

In più, ci sono anche percorsi strutturati e disegnati per apprendere un determinato ambito della generative AI in X giorni. Un esempio su tutti è il percorso formativo 3-day RAG roadmap, che direi veramente essere “low floor, wide walls and high ceiling”.

👅Etica & regolamentazione & impatto sulla società. L'AI americana soffocherà la cultura europea? La sfida è aperta!

"C'è uno squilibrio di potere in termini di quantità e qualità dei dati di addestramento: basta pensare a quanto sia grande la Wikipedia in inglese rispetto alle sue versioni in altre lingue", ha dichiarato Sebastian Ruder, ricercatore presso l'azienda canadese di AI, Cohere.

Questo è il tema centrale dell’approfondimento che ti consiglio oggi, pubblicato sul portale europeo di Politico, dal titolo piuttosto esplicativo: "Will American AI kill European culture?".

Il rischio che la diffusione della generative AI, i cui motori (LLM) sono in gran parte americani, possa accentuare il fenomeno winner-take-all anche in ambito culturale è un tema attuale e, a mio parere, preoccupante.

Ne ho parlato anche in un’intervista recente, in cui commentavo il pericolo che l’uso di dati sintetici possa portare, col tempo, a un “collasso” degli LLM. Ritengo che questo rischio esista, ma che possa essere gestito almeno nel medio periodo. Più complesso e insidioso è invece il fenomeno della polarizzazione verso culture specifiche, come quella anglo-americana, che beneficia di una maggiore quantità di dati grazie alla diffusione della lingua inglese e alla predominanza dei contenuti con cui vengono addestrati questi modelli di intelligenza artificiale. Il rischio più grande, in questo senso, è la perdita della diversità culturale su larga scala, un fenomeno che può essere paragonato alla perdita di biodiversità negli ecosistemi naturali, accelerata dalla crescita della popolazione mondiale negli ultimi cento anni.

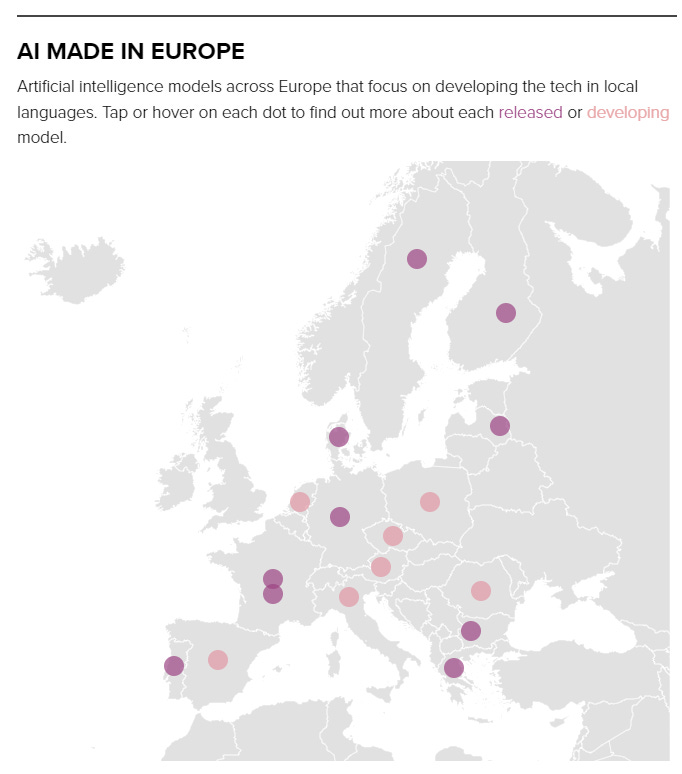

Nell’articolo di Politico, che descrive molto bene questo fenomeno, suggerisce come possibile soluzione la creazione di modelli linguistici nazionali, in grado di essere più centrati sui testi e documenti delle culture locali. C’è anche una rappresentazione interessante che mostra una panoramica su scala europea: se clicchi (nell’articolo originale) sopra le singole nazioni, puoi vedere progetti nazionali di LLM in corso.

Tuttavia, ho dei dubbi su questa soluzione a causa degli enormi costi associati a tali progetti. Inoltre, se questi modelli non raggiungeranno una qualità paragonabile agli LLM di punta, sarà difficile accettare un compromesso tra prestazioni qualitative e maggiore diversità culturale.

Sono convinto che questo problema debba essere affrontato su scala globale, incentivando soluzioni che minimizzino il rischio di una tale perdita. Dopotutto, anche un progetto globale e non recente come Wikipedia sta ancora affrontando questa sfida.

Se hai ulteriori suggerimenti e riflessioni sui temi di questo numero o per migliorare questa newsletter scrivimi (st.gatti@gmail.com) o commenta su substack.

Se ti è piaciuta e non sei ancora iscritto lascia la tua mail qui sotto e aiutami a diffonderla!

Alla prossima!

Articolo molto interessante. Da anni mi appassiona il tema del costo, prezzo e valore dei dati, e il paragone con le commodities, come oro e petrolio, emerge spesso, sebbene sia a volte calzante e altre meno. Trovo utile distinguere tra dati proprietari, con esclusività o limitazioni di accesso (come quelli offerti da piattaforme specializzate come Quandl), e dati non proprietari/esclusivi, per i quali è più facile immaginare un "prezzo di mercato." Un esempio sono i dati di web scraping: qui, sebbene il valore vari da utente a utente, il prezzo si allinea attorno al costo di estrazione (Data Boutique, ad esempio, funge da exchange per questo tipo di dati).