For my English speaking friends, click here for the translated version

Ciao,

sono Stefano Gatti e questo è il centocinquantatreesimo numero della newsletter LaCulturaDelDato: dati & algoritmi attraverso i nostri 5 sensi. Le regole che ci siamo dati per questo viaggio le puoi trovare qui.

🚀 Questa puntata è sponsorizzata da Data Masters

Esplora le Agentic Applications, l'innovativa frontiera nell'automazione intelligente del lavoro. Unendo la forza di modelli linguistici all'avanguardia come GPT-4, Llama, Google Gemma, Phi-3 e i più avanzati LLMs Open Source, con i recenti progressi nello sviluppo di sistemi RAG, potrai creare sofisticati sistemi decisionali autonomi, dotati di abilità flessibili per agire, interagire e decidere in modo proattivo.

Un'Agentic Application interpreta il contesto aziendale, prevede i bisogni dell'utente e intraprende azioni mirate, realizzando scenari d'uso concreti e tangibili. Questi sistemi innovativi sono in grado di processare vasti volumi di informazioni, esaminare dati complessi e offrire soluzioni su misura, tutto in tempo reale.

Se vuoi essere all'avanguardia nello sviluppo di applicazioni di Intelligenza Artificiale, sviluppare sistemi RAG in locale, avendo un controllo completo sui tuoi dati sensibili puoi acquisire padronanza completa grazie alla AI Agentic Applications Masterclass con LangChain. La Masterclass più avanzata in Italia promossa da Data Masters che ti insegnerà a:

Unificare la tua base di conoscenza (documenti aziendali, sito web, excels, e tanto altro)

Orchestrare i large language models

Creare la tua Local GPT

Sviluppare le tue Agentic Applications

Il corso include 7 lezioni in diretta con i docenti, che si tengono dopo le 18, pensate per adattarsi ai tuoi impegni lavorativi ed è in partenza il 27 febbraio. Scopri il programma completo.

📌 Chi è Data Masters?

Data Masters è una Tech Academy italiana che offre percorsi di formazione per professionisti e aziende in Data Science, Machine Learning e Intelligenza Artificiale.

Ed ora Ecco i cinque spunti del centocinquantatreesimo numero:

👀 Data Science. Come migliorare le decisioni con dati, AI e… un buon modello

Pur essendo consapevole che tutti i modelli che costruiamo della realtà sono inevitabilmente sbagliati, o quantomeno una sua rappresentazione molto approssimata, sono sempre stato – e continuo a essere – un grande appassionato di questi artefatti. Perché? Perché offrono uno dei migliori modi per condividere processi e progetti di miglioramento con altri, oltre a costituire strumenti potentissimi per accelerare l’innovazione su larga scala. 🚀

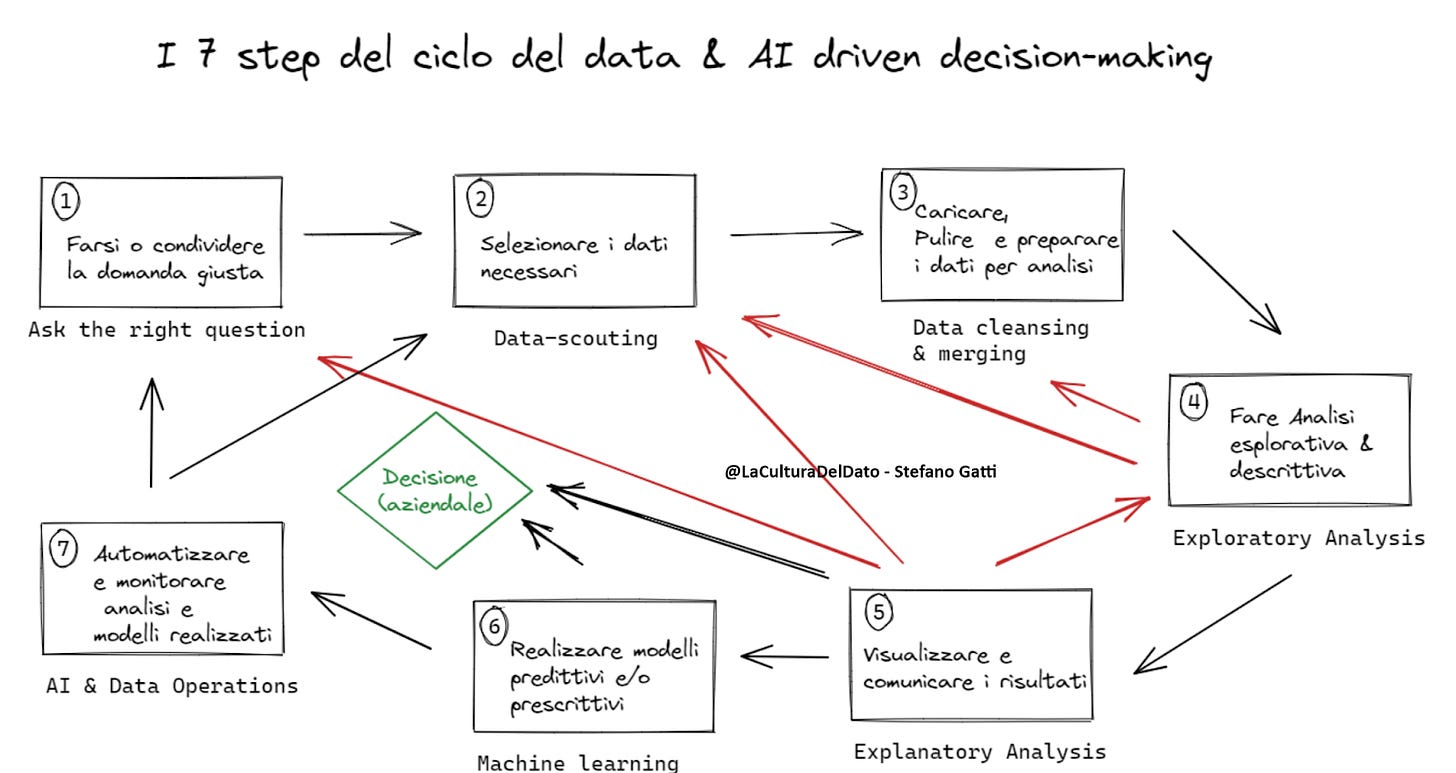

Vista la mia passione e il percorso che ho seguito (e sto ancora seguendo) nella vita, ho riflettuto a lungo su come si sia evoluto il processo decisionale all’interno delle organizzazioni e su come stia cambiando grazie ai dati e all’intelligenza artificiale. Nei vari contesti in cui ne parlo – dal corso universitario che tengo all’Università Cattolica, agli interventi che faccio in aziende o in altri ambiti – utilizzo questo modello per spiegare le diverse fasi del processo decisionale e mostrare come pratiche, strumenti e comportamenti delle persone possano migliorarlo, rendendolo più fluido ed efficace.

Non pretendo che sia il modello migliore né il più esaustivo, ma ho sperimentato sul campo quanto sia adatto al mio modo di raccontare il presente (e un pezzo di futuro) per discuterne con altri. Ovviamente, a seconda del contesto, si arricchisce di nuove considerazioni e tematiche in ciascuna delle sette fasi.

A proposito di modelli – stavolta più specifici per il mondo della data science, pur con alcune sovrapposizioni logiche con il mio – ho trovato molto completa e con il giusto livello di semplicità la rappresentazione proposta da

in questo post.Per concludere, non con un modello ma con due approfondimenti che arricchiscono e completano i due modelli che ti ho presentato, ti consiglio:

Un paper che fa il punto su come gli strumenti di Generative AI possano facilitare i vari step del processo decisionale con la data science.

Un post di Ajit Joaker, in cui suddivide le decisioni che prendiamo con i dati in quattro macro categorie:

Statistical Decisions

Machine Learning Decisions

Deep Learning Decisions

Autonomous Decisions – AI

Come tutte le classificazioni, è discutibile, ma offre un ottimo punto di partenza. 📌

👂🏾Organizzazione e cultura dei dati e algoritmi nelle organizzazioni. Sei forme di potere, ma nel mondo dei dati ne contano (soprattutto) due!

“I dati e le informazioni sono potere”.

Quante volte hai sentito questa affermazione all’interno delle nostre organizzazioni? Probabilmente molte. Spesso per “giustificare” i comportamenti di chi gestisce una conoscenza rilevante in forma implicita o tacita o, dato che siamo in un contesto di data-expert, per limitare l’accesso a basi di dati o documentazione tecnica sulla semantica dei dati stessi.

In senso più ampio, infatti, i dati e le informazioni che se ne possono estrarre sono diventati un asset sempre più strategico per le aziende. Te ne ho parlato spesso citando i lavori di uno dei più importanti esperti mondiali, Abraham Thomas.

Ma oggi non voglio concentrarmi su questo, bensì su un particolare tipo di potere: quello dell’esperto, su cui si basa in larga parte la cosiddetta leadership tecnica.

Facciamo un passo indietro e proviamo a inquadrare questa tassonomia di poteri, aiutati da una serie di articoli di Sheril Mathews, all’interno di un framework sviluppato da John French e Bertram Raven. Questi due psicologi sociali, nel 1959, hanno pubblicato uno studio fondamentale sulla natura del potere e dell’influenza nella leadership, che puoi leggere qui nella sua forma originale grazie a Internet Archive (o nella versione integrata con il sesto potere, quello informativo qui).

French e Raven hanno identificato sei forme base di potere:

Potere di ricompensa (Reward Power) → La capacità di offrire incentivi per motivare.

Potere coercitivo (Coercive Power) → L’uso di punizioni o minacce per ottenere conformità.

Potere legittimo (Legitimate Power) → Derivante dalla posizione o dal ruolo gerarchico.

Potere esperto (Expert Power) → Basato sulla conoscenza e competenza del leader.

Potere di riferimento (Referent Power) → Fondato sul carisma e l’ammirazione.

Potere informativo (Informational Power, aggiunto nel paper del 1965) → Basato sull’uso strategico delle informazioni.

Nel mondo dei data-expert, il potere esperto, insieme a quello informativo, è sicuramente il più utilizzato e il più efficace.

Sheril Mathews, nell’articolo che ti consiglio di leggere (sia che tu sia già un leader, sia che tu aspiri a diventarlo), lo descrive in modo dettagliato e preciso. Ne spiega chiaramente le componenti chiave: le mie preferite sono credibilità e track record. Ma ne evidenzia anche le sfide: la sottovalutazione delle soft skills è, a mio avviso, una delle più critiche per la crescita di molti leader e fornisce un sacco di consigli utili. Avrei voluto avere queste informazioni in questa forma qualche decennio fa! 😉

Buona lettura!

👃Investimenti in ambito dati e algoritmi. Investire in AI? Il futuro è ibrido (e le startup lo sanno già)

Da diversi mesi, in diverse sezioni e numeri della newsletter, ti sto parlando di Hybrid AI. Dopo l’ubriacatura, la gioia e anche la meraviglia scatenate dal nuovo flusso di Generative AI, reso visibile a tutti con il lancio di ChatGPT nel novembre del 2022, sta emergendo una nuova consapevolezza. Questa consapevolezza parte da coloro che, in modo molto pratico, usando dati e intelligenze artificiali stanno cercando di creare valore per le aziende e per le persone nella loro vita quotidiana e lo fanno sempre più mixando il meglio delle varie tipologie di intelligenze, non solo quella generativa!

Infatti quando parlo di Hybrid AI, intendo l’utilizzo congiunto dell’AI tradizionale — descrittiva e predittiva per intenderci —e dell’AI generativa per risolvere problemi o sviluppare progetti. Invece di addentrarmi in una spiegazione ulteriore del concetto, preferisco segnalarti, come approfondimento di oggi, un articolo di Bernard Marr su Forbes dal titolo “Why Hybrid AI is the Next Big Thing in Tech”. Questo articolo (insieme al video di 4 minuti che lo accompagna) spiega cosa sia l'Hybrid AI con esempi molto concreti, tratti da diversi settori industriali, già in produzione.

E, visto che siamo nella sezione dedicata agli investimenti, ti segnalo che a mio giudizio l’approccio della Hybrid AI diventa ancora più rilevante quando si tratta di valutare un progetto di innovazione, una startup o un investimento nel settore dell’intelligenza artificiale oggi.

Su questo tema ti consiglio un articolo del solito acuto Rex Woodbury. Nel suo recente pezzo “The Age of Fragmentation: AI’s Impact on Content and Code”, Woodbury propone riflessioni davvero interessanti sull’evoluzione degli investimenti nel nostro settore. Dati alla mano, evidenzia la tendenza sempre più ampia di frammentazione nei mercati, per poi approfondire l’impatto specifico sull’intelligenza artificiale con scenari futuri che si stanno lentamente delineando. Tra i suoi spunti più incisivi, cito un passaggio con cui mi trovo particolarmente d’accordo in cui si parla di valore dell’AI:

“Dov'è il valore? Nelle applicazioni. Dov'è la difendibilità? Nelle reti.”

Tradurrei "reti" nel suo significato più vicino a quello di community. E oltre alle reti, aggiungerei senza dubbio la qualità dell’esperienza d’uso. Ma su questo ci torneremo più avanti... 😉

🖐️Tecnologia (data engineering). Data Lakehouse: vintage? No, più attuale che mai!

Tre anni fa, questo era stato l’argomento più apprezzato nel trentaduesimo numero della newsletter. Oggi potrebbe sembrare quasi vintage, in un panorama dominato dal racconto entusiasta della generative AI, che sembra capace di ogni prodigio persino nel mondo più tech dei dati e dei database.

Sai già che sono molto positivo riguardo alle capacità trasformative della generative AI, ma non da sola (vedi il punto precedente sulla HybridAI). La vera potenza si sprigiona quando lavora insieme ai dati, il carburante essenziale, soprattutto se all’interno delle organizzazioni vengono mantenuti in buon ordine. :-)

Per questo, il concetto architetturale di lakehouse è tutt’altro che superato: è ancora oggi assolutamente rilevante. Scrivevo quasi tre anni fa, e lo confermo senza esitazioni:

“Non sempre in medio stat virtus, ma in questo caso sembra proprio di sì. Una delle principali evoluzioni architetturali del mondo dei dati nelle grandi organizzazioni – e probabilmente anche in quelle non grandissime – è proprio il data lakehouse. Questa tecnologia coglie gli aspetti migliori delle più tradizionali architetture dei data warehouse, integrandoli con la maggiore duttilità dei data lake, soprattutto per gli utilizzi più algoritmici. Ormai ci sono tantissime offerte e relative descrizioni da parte dei vendor, che illustrano questo nuovo paradigma tecnologico, ma ti consiglio un articolo chiaro e completo di Bernard Marr, che spiega bene il perché della trasformazione in corso…”

Buon ripasso o buona lettura! :-)

👅Etica & regolamentazione & impatto sulla società. Clio: il Google Trends dell’IA? Anthropic studia le nostre chat

“I dati e le informazioni sono potere.”

No, non è un errore di copia-incolla dalla seconda sezione di oggi della newsletter. Anche qui parliamo di dati e conoscenza come strumenti di vantaggio competitivo e, per certi versi, di potere.

Uno degli aspetti spesso trascurati da chi analizza dall’esterno le aziende con molte interazioni con gli utenti, anche quando questi ultimi utilizzano gratuitamente i loro servizi, è la capacità di capire come questi servizi vengono usati e quali contenuti vengono cercati o inseriti nelle interazioni con i servizi stessi. Nel caso della ricerca sul web, per esempio, questo offre due vantaggi concreti: da un lato permette di individuare le evoluzioni più utili e remunerative dei servizi offerti, dall’altro aiuta a comprendere i trend di mercato segmentati per tipologia di utente.

Un esempio classico di questo meccanismo è Google Trends, lo strumento di Google che mostra cosa e come le persone stanno cercando nel mondo. Se lo conosci ma non lo hai mai usato per almeno una decina di minuti, ti consiglio di farlo. Io l’ho trovato molto utile in diversi progetti e momenti della mia vita lavorativa (e non solo).

L’approfondimento che ti propongo oggi segue la stessa logica, ma applicata ai dati e alle interazioni dei nuovi strumenti basati su LLM (modelli linguistici di grandi dimensioni), che – come ti dico da mesi – stanno gradualmente sostituendo la classica ricerca sul web.

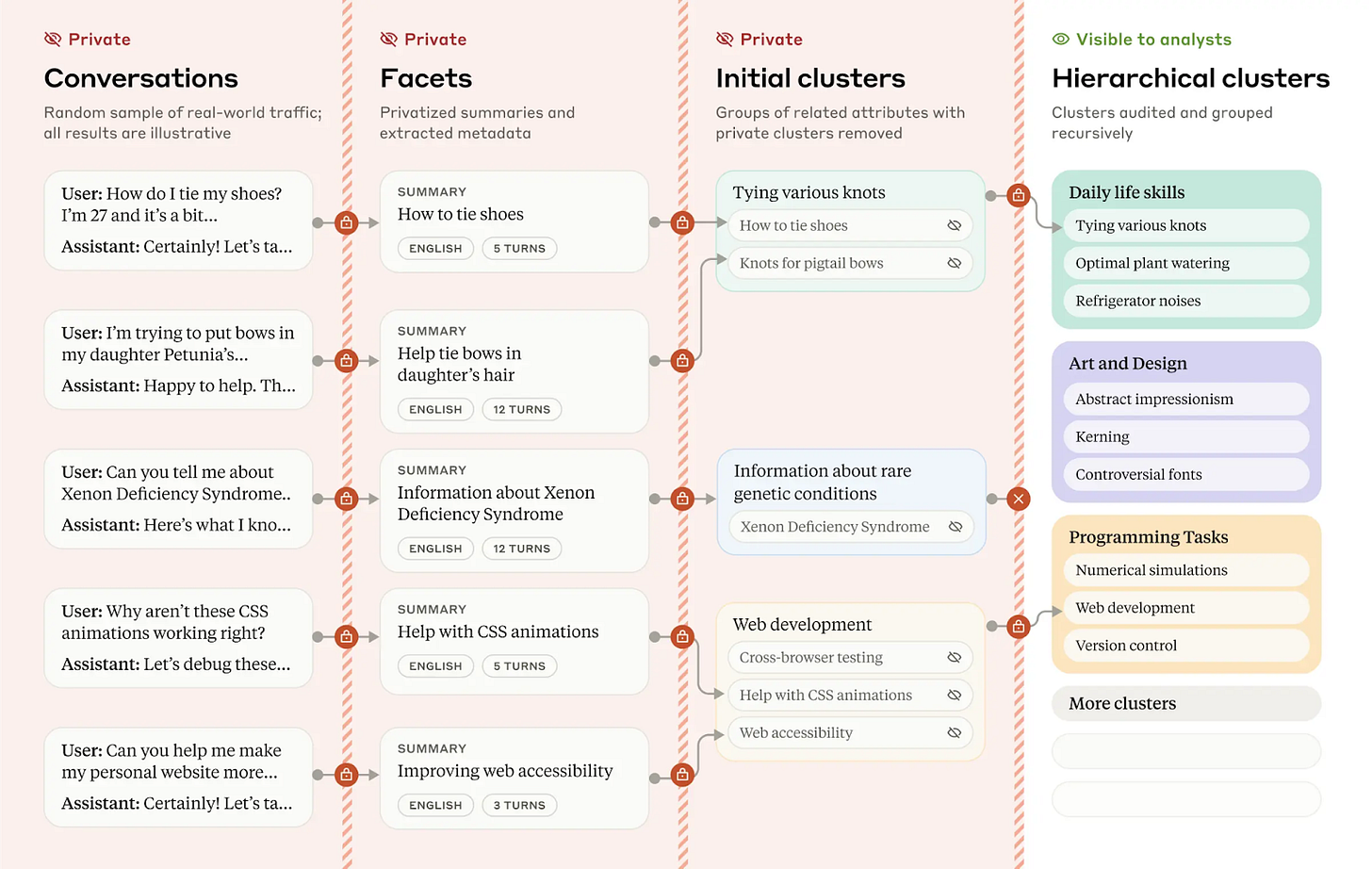

A dicembre, Anthropic, l’azienda dietro lo sviluppo di Claude.ai, ha annunciato Clio, un progetto simile a Google Trends, ma basato sulle interazioni degli utenti con il loro chatbot. Ti consiglio di leggere il loro post di annuncio e, se ti interessa approfondire, di dare un’occhiata al paper, che racconta molto bene la parte più tecnica del progetto.

Il progetto è raccontato molto bene e fornisce informazioni decisamente interessanti e utili per avere una prospettiva diversa e più interna anche dell’evoluzione della generative AI.

Ecco come Anthropic presenta Clio:

“Per cosa si usano i modelli di intelligenza artificiale? Nonostante la popolarità in rapida crescita dei modelli linguistici di grandi dimensioni, finora abbiamo avuto poche informazioni su come vengono utilizzati.

Non si tratta solo di curiosità o di ricerca sociologica. Sapere come le persone utilizzano effettivamente i modelli linguistici è importante per ragioni di sicurezza: i provider compiono sforzi considerevoli nei test pre-deployment e utilizzano sistemi di sicurezza per prevenire gli abusi. Tuttavia, l'ampiezza e la diversità di ciò che i modelli linguistici possono fare rendono molto difficile la comprensione dei loro usi, per non parlare di qualsiasi tipo di monitoraggio completo della sicurezza. … Claude insights and observations, o semplicemente “Clio”, è il nostro tentativo di rispondere a questa domanda. Clio è uno strumento di analisi automatizzato che consente di analizzare, nel rispetto della privacy, l'uso del modello linguistico nel mondo reale. Ci fornisce informazioni sugli usi quotidiani di claude.ai in modo analogo a strumenti come Google Trends. Inoltre, ci sta già aiutando a migliorare le nostre misure di sicurezza. In questo post, che accompagna un documento di ricerca completo, descriviamo Clio e alcuni dei suoi risultati iniziali.”

L’iniziativa è lodevole e degna di nota, ma è evidente che dietro ci sia anche una strategia di marketing e, probabilmente, un tentativo di capire se queste informazioni potranno essere monetizzate direttamente o indirettamente in futuro.

D’altronde, studiare come gli utenti interagiscono con una piattaforma è un vantaggio che nessuna azienda operante in settori dinamici e in forte sviluppo dovrebbe trascurare. Se poi questo viene fatto con un buon storytelling e con la condivisione di dati utili alla comunità, tanto meglio!

Se hai ulteriori suggerimenti e riflessioni sui temi di questo numero o per migliorare questa newsletter scrivimi (st.gatti@gmail.com) o commenta su substack.

Se ti è piaciuta e non sei ancora iscritto lascia la tua mail qui sotto e aiutami a diffonderla!

Alla prossima!

Sempre preziosa questa newsletter. Il paper su data analysis è applicabile a moltissimi lavori cognitivi (consulenza di direzione in primis). E l’AI ibrida è quello che sta già accadendo. Grazie Stefano