For my English speaking friends, click here for the translated version

Ciao,

sono Stefano Gatti e questo è il centosettantaquattresimo numero numero della newsletter LaCulturaDelDato: dati & algoritmi attraverso i nostri 5 sensi. Le regole che ci siamo dati per questo viaggio le puoi trovare qui.

Ecco i cinque spunti del centosettantaquattresimo numero:

👂🏾Organizzazione e cultura dei dati e algoritmi nelle organizzazioni. Perché le aziende non riescono a stare dietro all’AI

“Questo è il divario tra capacità e assorbimento: i laboratori all'avanguardia stanno avanzando più rapidamente di quanto l'economia tradizionale riesca a tenere il passo. L'attuale generazione di IA è già abbastanza potente da rivoluzionare il nostro modo di lavorare, ma le aziende stanno assorbendo queste capacità molto più lentamente di quanto i laboratori le stiano migliorando. Non li biasimo. I prezzi si dimezzano ogni sei mesi, i modelli rimangono stocastici, il che complica l'affidabilità, e il know-how manageriale è scarso.”

Questo è il cuore di un articolo di cui condivido pienamente l’analisi, e che fotografa benissimo il problema più importante che (quasi) tutte le organizzazioni hanno oggi con l’AI: quello che Azeem Azhar chiama giustamente “capability-absorption gap”. L’articolo è parzialmente sotto paywall, ma già nella parte accessibile a tutti offre un’ottima chiave di lettura del presente.

Immagine generata con chatGPT-images

Alla base di questo gap, Azhar individua tre grossi freni su cui sia le organizzazioni sia le singole persone dovrebbero lavorare:

Il tempo di apprendimento, che è più lento della velocità con cui migliorano le AI.

La complessità della tecnologia, che pesa soprattutto all’interno delle organizzazioni, spesso incapaci di trovare assetti organizzativi adatti a facilitarne l’adozione.

Il non determinismo e la scarsa affidabilità, che rendono la tecnologia ancora inutilizzabile in alcuni ambiti e ne frenano l’adozione da parte dei più scettici.

Di fronte a tutto ciò, è ancora più importante, a mio giudizio, seguire, sia a livello individuale che aziendale, alcuni principi che arrivano dall’esperienza agile:

👉 più tempo alla pratica che alla normazione del suo utilizzo

👉 più spazio all’uso in progetti, anche piccoli ma reali, che alla formazione in contesti artificiali

👉 più intelligenze artificiali da scegliere a seconda dei casi, piuttosto che una soluzione unica e monolitica

Buona pratica!

🖐️Tecnologia (data engineering). DuckDB: il coltellino svizzero dei database

Negli ultimi mesi, soprattutto da quando a metà 2024 è stata rilasciata la prima versione stabile, si sente parlare sempre più spesso di DuckDB, un database che sta rivoluzionando il modo in cui data analyst e data scientist lavorano con i dati, soprattutto in locale.

Dal momento che lo sto usando per un progetto personale, e l’esperienza finora è decisamente positiva, l’approfondimento di oggi è proprio dedicato a lui 🙂

DuckDB è un database relazionale-colonnare, compatibile con SQL, pensato per girare in-process (cioè direttamente all’interno del tuo script o notebook), senza bisogno di un server. In altre parole: è come avere un piccolo motore analitico in tasca, pronto a eseguire query complesse direttamente su file Parquet, CSV o Pandas DataFrame, con performance sorprendenti. DuckDB nasce da una ricerca al CWI (Centrum Wiskunde & Informatica) di Amsterdam, grazie a Hannes Mühleisen e Mark Raasveldt, oggi anche fondatori della startup DuckDB Labs.

Viene spesso paragonato a SQLite, ma le differenze sono sostanziali. SQLite è pensato per transazioni leggere e storage persistente, mentre DuckDB è ottimizzato per carichi analitici: sfrutta l’execution vettoriale, supporta operazioni su grandi volumi in memoria e ha un ecosistema nativamente pensato per integrarsi con gli strumenti del mondo data science.

Uno dei suoi punti di forza è proprio l’essere un ponte naturale tra SQL, Python e sistemi di storage persistente. Puoi scrivere una query SQL, leggerla da un file Parquet o da un DataFrame Pandas, e salvare il risultato su disco, tutto in poche righe di codice. Niente setup complicati, niente deployment: apri un notebook, importi duckdb, e sei subito operativo.

Se vuoi farti un’idea di come funziona e come si integra facilmente nei progetti che stai facendo, ti consiglio questo video divulgativo molto ben fatto.

Infine, sentirai spesso parlare anche di MotherDuck, e vale la pena chiarire la differenza.

DuckDB è open-source, gratuito, non richiede connessioni remote e salva i dati dove vuoi tu.

MotherDuck è una piattaforma cloud commerciale che estende DuckDB con funzionalità di collaborazione, storage remoto, sicurezza e query ibride (locale + cloud). È pensato per team che vogliono i vantaggi di DuckDB ma con gestione centralizzata e scalabilità.

Entrambi condividono lo stesso motore SQL, il che significa che puoi scrivere una query una sola volta e farla girare ovunque. In sintesi: se usi Pandas o SQL e lavori su dati tabellari, DuckDB è uno strumento che vale davvero la pena provare.

👃Investimenti in ambito dati e algoritmi. Startup in incognito: strategia brillante o mito da sfatare?

Nel gergo delle startup, stealth mode indica una fase in cui un’azienda sceglie deliberatamente di operare nel massimo riserbo. L’obiettivo è evitare l’attenzione del pubblico, dei media e soprattutto dei concorrenti, mentre si sviluppa un nuovo prodotto o servizio. In questa modalità, i founder limitano al minimo la comunicazione esterna: niente sito web, nessun annuncio pubblico, a volte nemmeno il nome dell’azienda è rivelato. È una strategia che si basa sull’idea che la segretezza possa offrire un vantaggio competitivo cruciale nei primi mesi di vita.

Francamente, sono sempre più convinto, con il passar del tempo, che questa modalità sia una forma velata e moderna di marketing, utile per attirare attenzione su di sé in una fase delicata dell’idea. E in un momento in cui il seed-strapping (come ti ho raccontato qualche puntata fa) sta diventando una modalità sempre più rilevante per raccogliere capitali.

Allo stesso tempo, penso che questa strategia vada in contrasto con alcuni dei principi fondamentali dello sviluppo agile di prodotti e servizi, e più in generale con quelli del lean start-up, ben raccontati da Eric Ries nel suo libro The Lean Startup, come ad esempio la logica dell’MVP e della co-creazione con i primi utilizzatori.

Molto meglio di me, condito da tanto sarcasmo e molti più dettagli, esprime questo punto di vista un ex-startupper e ora investitore che scrive spesso di questi temi e che ti cito di frequente: Jason Cohen. Nel suo post “Stealth mode and other f’ing brilliant strategies” esprime tutto il suo disappunto su questa pratica e su tanti altri falsi miti che le ruotano attorno ad essa.

La lettura è davvero piacevole e divertente 😄

Il mio parere (e quello di Jason Cohen) è solo uno dei tanti punti di vista. Se, leggendone, ti vengono in mente altre riflessioni o esperienze, scrivimi: mi interessa davvero continuare a discuterne!

👀 Data Science. Annuario Istat: i dataset che ogni data analyst dovrebbero avere tra i preferiti

Come (quasi) ogni anno, credo sia doveroso dedicare spazio alla pubblicazione più importante per qualità e quantità di dati relativi al nostro Paese e al suo andamento storico. Se avessi un minimo di potere di influenza sulle politiche scolastiche, renderei fortemente consigliata (non dico obbligatoria, per non sembrare un dittatore benevolo 😄) la lettura almeno della sintesi (24 pagine in tutto) dell’Annuario Statistico Italiano dell’ISTAT.

È uscita da qualche mese l’edizione 2024, e la fotografia che viene fornita, non dico dalle 908 pagine dell’edizione integrale, ma già solo nella sintesi, è unica per chiunque debba prendere decisioni informate e il più possibile obiettive. E di decisioni ne prendiamo tutti, anche solo per decidere periodicamente a chi delegare le scelte politiche.

Visto che questa non è una newsletter politica e siamo nella sezione dedicata alla data science, penso che il documento e i riferimenti agli open data su cui si basa l’annuario possano essere di grande utilità per ogni data scientist o data analyst che lavori in qualunque tipo di organizzazione. Ho usato, e continuo a usare, i dati ISTAT in diversi progetti: sono tra i dataset meno conosciuti ma più ricchi, specialmente nei contesti in cui la conoscenza del territorio e della popolazione italiana è cruciale.

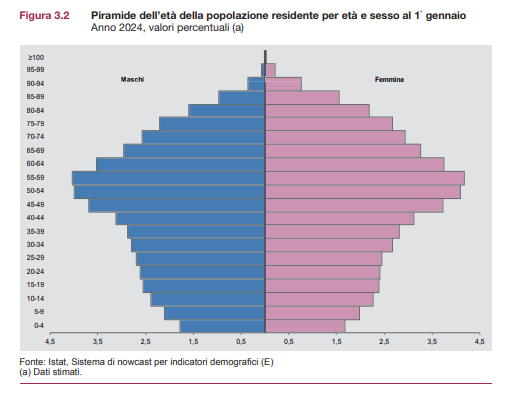

Non ti faccio qui la sintesi dell’annuario … tranquillo! Basta davvero dedicare 30 minuti all’anno alle 24 pagine dell’executive summary, ma se devo suggerirti una delle 24 sezioni in cui è diviso, sicuramente per ricchezza e orizzontalità d’uso ti segnalo la sezione 3: Popolazione e Famiglie. Anche solo per capire meglio come la tua customer base si mappa sulla popolazione italiana e sui suoi trend 📊

👅Etica & regolamentazione & impatto sulla società. L’avvocato nerd che ti insegna a parlare con l’AI

Era stato l’approfondimento più cliccato nella newsletter 53, all’interno di una delle prime interviste che avevo realizzato in questo progetto.

Massimiliano Nicotra era, ed è, un amico. Abbiamo avuto (e abbiamo) due percorsi professionali diversi, ma ci accomuna la passione per la tecnologia e la curiosità di esplorare anteprime di futuri. Lui lo fa molto bene da “avvocato nerd”, come ama definirsi in maniera forse riduttiva ma indubbiamente affascinante.

L’approfondimento che vi era piaciuto, quasi tre anni fa, segnava, per lui, l’inizio di un percorso di esplorazione sull’uso della generative AI in ambito giuridico. Lo aveva fatto, come spesso gli riesce, in modo molto visionario ma soprattutto molto pratico, condividendo modi intelligenti per interagire con le nuove intelligenze artificiali generative in una newsletter domenicale.

Il progetto, nel tempo, si è arricchito. Oltre alla newsletter su LinkedIn è arrivato un sito omonimo della newsletter, dove Massimiliano raccoglie in maniera organizzata tutti i contenuti che man mano ci regala.

Se lavori in ambito legale, non puoi perdertelo. Ma anche per me è una risorsa preziosa, perché offre indicazioni e test molto utili soprattutto sull’arte del prompt engineering.

Tra i miei post preferiti:

👉 la guida ai prompt per avvocati

👉 la guida definitiva per creare il tuo DPO personale

Buona esplorazione! 🚀

Se hai ulteriori suggerimenti e riflessioni sui temi di questo numero o per migliorare questa newsletter scrivimi (st.gatti@gmail.com) o commenta su substack.

Se ti è piaciuta e non sei ancora iscritto lascia la tua mail qui sotto e aiutami a diffonderla!

Alla prossima!

DuckDB + Dbeaver, l'accoppiata vincente.

E' uno dei primi strumenti con cui poter comodamente produrre files parquet, che poi sono universalmente utili.

Con un PC decente si fanno analisi che poco tempo fa avrebbero richiesto un cluster.