For my English speaking friends, click here for the translated version

Ciao,

sono Stefano Gatti e questo è il centesimo numero della newsletter LaCulturaDelDato: dati & algoritmi attraverso i nostri 5 sensi. Questa, la centesima, è un’edizione speciale perché come ti avevo condiviso (e l'idea ha riscosso l'approvazione dell'84% dei partecipanti che avevano espresso un parere) sarà diversa da tutte le altre e divisa in tre parti:

👅 Nella prima parte AMA (Ask Me Anything) risponderò a una serie di domande formate dall’unione di quelle che faccio nelle puntate dispari all’intervistato di turno con quelle che mi avete chiesto via mail e nell'ultima survey.

🖐️ Nella seconda parte, una sorta di HOW-To show, vi racconterò come realizzo questa newsletter (me lo avete chiesto in molti) e soprattutto come uso dati e intelligenza generativa nel realizzarla.

🙏 La terza sono i ringraziamenti che si mettono alla fine per essere sicuro di avere almeno un lettore di tutta la newsletter 🙂

Cominciamo …

👅 AMA (Ask Me Anything)

Presentati

Ingegnere, dopo alcune esperienze nel mondo della Qualità e dell’Organizzazione Aziendale in Pirelli, ho cominciato ad occuparmi di progetti relativi a dati e tecnologia in diversi settori nel mondo dei servizi. Come Head of Innovation & Data Sources in Cerved ho supportato l’evoluzione dell’azienda in ambito big data sia attraverso team di data experts sia attraverso il paradigma dell’Open Innovation con investimenti strategici in start-up e aziende innovative. Oggi lavoro in Nexi come Head of Data & Analytics. Da data lover, come amo definirmi, supporto in particolare tutti i ruoli il cui nome comincia con la parola “data”, per essere sempre più valorizzati e ascoltati in azienda.

Il mio ruolo tra 10 anni sarà ... (continua la frase come fossi GPT-10) in ambito education del settore tech. Mi piace lavorare con i giovani e soprattutto con le persone che stanno muovendo i primi passi all’interno delle organizzazioni. Credo che riuscire a renderli operativi e motivati in ambiti strategici sia sempre più importante. Non sarà più possibile essere in azienda senza saper lavorare bene con i dati e l’intelligenza artificiale. Per questo la parte di formazione sarà molto più importante di quello che è già oggi.

Quale è la sfida più importante che il mondo dei dati e algoritmi ha di fronte a sé oggi?

Superare le barriere tra mondo della tecnologia e business è la sfida più importante che il mondo aziendale ha di fronte. Solo una sintesi, in senso hegeliano, può portare a vincere questa sfida anche attraverso un cambio di prospettiva da entrambe le parti. Imparare un po’ di coding, di statistica e di metriche di datascience è necessario al business per sapere cosa si può fare con i dati mentre avere maggior contatto con il Cliente è importante per i data-expert per essere attivi nel co-creare prodotti e soluzioni data & ai driven.

Segnalaci il progetto o la risorsa nel mondo dei dati di cui non potresti fare a meno …

Fino a 18 mesi fa avrei detto solo Wikipedia. Ci sono molte voci, soprattutto in Inglese, che hanno contenuti “low floor & high ceiling”, come si dice nel mondo anglosassone, anche per il mondo dei dati. Ti fanno capire facilmente il concetto base ma puoi approfondire a piacere attraverso i numerosi rimandi a risorse interne ed esterne. Un esempio su tutti è la voce inglese sulla confusion matrix https://en.wikipedia.org/wiki/Confusion_matrix che è un punto da cui partire per avere una panoramica (e un ripasso) sulle metriche dei problemi di classificazione in data science. Oggi mi sento di affiancare a Wikipedia sicuramente ChatGPT-4.

Perché scrivi la newsletter?

Per rispondere prendo a prestito il sottotitolo di un post di

Ci sono anche una serie di motivi legati allo strumento della newsletter, in cui credo molto che ha sintetizzato molto bene in questo post su linkedin .

Inoltre essere all’interno di un network di professionisti, Newsletterati, che scrivono newsletter molto più popolari e frequentate della mia mi ha fatto imparare molte cose su questo mondo.

Come mai è cambiata molto, perlomeno in lunghezza, la newsletter in questi 2 anni?Come commento una lettrice mi aveva scritto paragonando la prima puntata ad un ottimo aperitivo che può restare tale o “degenerare” in un bel banchetto. Ecco credo sia degenerato in un buffet 🙂. Effettivamente se guardo le 4 regole da cui ero partito e che trovi qui, ne ho infrante almeno 3 in molte newsletter. Detto questo in due anni sono cambiato e anche il pubblico della newsletter è diventato 13 volte più ampio. Non escludo comunque di considerare nel viaggio altri cambiamenti e anche magari tornare alle origini …

Come hai fatto a fare 100 numeri senza saltarne?

Tradendo la mia passione per la corsa, uso una frase con cui rispondo quando mi chiedono come si fa a fare una maratona? “un chilometro dopo l’altro”.

Investi in quello che studi?

A volte con alterne fortune. Ho imparato invecchiando a investire soprattutto in qualcosa quando mi diverte occuparmene. Diciamo che mi piace molto studiare gli investimenti con i dati. E se fra 10 anni, come dicevo sopra, non lavorerò in ambito educativo del settore tech mi piacerebbe lavorare in un Venture Capital o dedicare parte del mio tempo a lavorare nel settore degli investimenti innovativi come ho fatto per un certo periodo della mia vita (in Cerved).

Perché si parla per lo più di AI quando molti altri ambiti dati sarebbero più utili ?

Perché l’AI e in particolare la Generative AI è diventata e diventerà sempre più l’interfaccia semplice e funzionale che mancava a tutto il mondo dei dati. Così come la ricerca di Google diventò nel 2000 l’interfaccia semplice e funzionale di tutto il web.

Con AI stiamo andando verso un mondo sintetico un grande Truman show ? Chi distinguerà reale da sintetico ? Come ?

Il sintetico è reale, semplicemente è qualcosa che non conosciamo bene e rappresenta qualcosa di diverso rispetto a quello che pensiamo. Anche Magritte nel “tradimento delle immagini” nel 1931 aveva messo in guardia da questo pericolo. Sono ottimista: troveremo il modo per distinguere quello che è prodotto dall’uomo e quello prodotto da intelligenze artificiali. Sarà solo un poco più difficile rispetto al 1931 …

In che direzione sta andando la Data Analysis? Verrà integrata o sostituita dall'AI?Come per la data science il futuro potrebbe biforcarsi come ho scritto nella prima parte della newsletter 92

Come vedi il knowledge management nell'era delle AI Generative? E’ uno dei temi che mi appassiona di più. Sarà l’età dell’oro del knowledge management per tutti i tool che sono usciti e usciranno. Il problema sarà saperli scegliere, saperli usare e integrare al meglio.

Quale sarà l’impatto dell’AI Act e come si scontrerà con l’innovazione?

Dipende da quanto sarà coesa la comunità Europea e quanto sarà intelligente e pragmatica l’applicazione dell’AI Act. Da convinto europeista sono moderatamente pessimista!

Cosa vedi dopo la cultura del dato? La cultura del pensiero critico, la cultura del pensiero aumentato o altro?

Lasciatemi arrivare alla puntata 420(42X10) e ve lo saprò dire 🙂.

Quali sono le prospettive future lavorative a seguito di un utilizzo di massa dell’AI e come cambieranno i lavori di oggi?

Ti rispondo in primis con la legge di Amara: “Tendiamo a sovrastimare gli effetti di una tecnologia nel breve periodo e a sottostimare i suoi effetti nel lungo periodo”. Meno di quanto pensiamo nel breve di più nel lungo periodo. Rimango ottimista sul risultato complessivo. Mi preoccupa di più la distribuzione di questo risultato complessivo.

Quali sono le differenze tra una data strategy concepita nel 2018/19 ad una futura 2024 ?

Ci si potrebbe scrivere un altro libro🙂 Per dirla brevemente nel 2024 molto più business e AI centrica rispetto a quella del 2018 dove la componente tecnologica e organizzativa aveva più spazio.

Cosa ne pensi di pyspark in alternativa a pandas e polars?

La scelta migliore, pyspark, più i progetti diventano grandi come moli di dati e più integrati in ambiti enterprise. Ma non dimentichiamoci che la maggior parte, numericamente parlando, di progetti in giro per il mondo non sono di questo tipo.

Come e dove ti sei formato per imparare ad usare l’AI?

I miei "segreti" sono background tecnico di base (laurea in ingegneria) e non smettere di studiare da quando mi sono laureato nel 1994. I Mooc (massive Open Online Courses) a partire dal primo corso di Coursera di Andrew Ng nel 2012 sono stato un grande strumento per il mio lifetime learning.

La scuola italiana è pronta ad inserire una vera e propria AI literacy nei suoi percorsi didattici per preparare studenti e studentesse al futuro?

No, non è affatto pronta, ma succederà comunque in maniera più destrutturata e a macchia di leopardo di quanto ci piacerebbe. Tutto grazie alla significativa spinta dei martiri-innovatori di cui è ricca la scuola italiana. Poi il tutto avrà una svolta quando sarà percepito come una grande emergenza nazionale: non siamo un popolo di pianificatori!

Quali prospettive per l'utilizzo della AI nella preparazione della maratona? Ci saranno allenatori virtuali basati sulla AI?

Se sono riuscito a stare sotto le tre ore (qui il racconto di quelle 2h58 di … emozioni) anche usando solo i dati senza AI non credo ce ne sia cosi tanto bisogno. Scherzi a parte, ci sono allenatori virtuali basati su AI già oggi e prendono anche buoni finanziamenti (guarda Runna che ha chiuso un seed da 5 milioni di sterline lo scorso Dicembre). Se sei un appassionato di running, di dati e di AI

Cosa deve fare un inesperto totale di AI per acquisire un primo set minimo di info di base utile per poi orientarsi nei vari approfondimenti?

In primis curiosità e tempo da dedicare a muovere i primi passi. Nella newsletter, forse troppo poco di frequente, inserisco approfondimenti semplici. Con qualcuno di voi, che mi ha scritto, sto facendo in modalità try & learn dei mini-percorsi per persone non tecniche. Se sei interessato scrivimi e poi se sarete tanti a farlo cercherò di creare qualcosa di più strutturato!

🖐️ HOW-TO show

Non è facile raccontare come realizzo la newsletter perché non è un processo completamente lineare, ma nel corso di questi quasi 2 anni ho cercato di standardizzarlo anche per definire e migliorare gli strumenti che mi aiutano a farlo. E da questo punto di vista l’avvento della generative AI è stata una spinta molto forte. Proviamo a procedere così: prima ti racconto grazie a tre schemi di flusso (che se mi legge qualche professore di algoritmi si disiscrive alla newsletter all’istante) le tre fasi principali di creazione e in fondo rispondo alle domande e alle curiosità che mi hai chiesto relative a questo argomento

Fase 1 - Selezione e gestione delle fonti

La fase di selezione e gestione delle fonti è la meno lineare e quella più distribuita nel tempo. Di fatto questa fase è la mia vita conscia … nel senso che a parte quanto dormo può capitare, anche per il lavoro che faccio, di avere segnalazioni di “cose interessanti” che riguardano Dati & AI. La difficoltà in questa fase di “raccolta” è di non perdersi nulla cioè di non dimenticarsi la valutazione di qualche spunto. Il punto dove preferisco ricevere link o suggerimenti di approfondimento è la mia mail personale (st.gatti@gmail.com) perché applicando rigorosamente il principio “Inbox zero" sono sicuro di non perdermi (quasi) nulla. Ma come immaginerete molti spunti non mi vengono mandati attraverso questo canale ma attraverso i più disparati (anche attraverso canali meno ideali per questi scopi, come WhatsApp). Comunque circa l’80% degli spunti mi arrivano via mail che di fatto rappresenta il mio collettore primario di approfondimenti. Non ho altri strumenti di collezione dei link ma ho cercato con il tempo di affinare l’attività, secondo me, più importante di questa fase e cioè il processo di valutazione che ho reso con tempo il più rapido possibile. Il processo di valutazione si base su due principi fondamentali:

Se l'approfondimento arriva da una fonte che ho qualificato cioè ritengo di valore (tecnicamente significa che è presente sulla mia area (tabella) dedicata su Airtable) sicuramente lo ritengo interessante e viene classificato come utile e viene inserito in quello che io chiamo “Pianificatore Google Sheet della Newsletter” e il cui funzionamento vi spiego nella fase 2

Se arriva da una fonte non qualificata, la maggioranza dei casi, il processo di selezione deve stare sotto i 3 minuti ma direi anche meno. In alcuni casi quando l’articolo è lungo, mi faccio aiutare dalla Generative AI e in particolare da un ChatGPTs istruito per questa parte (fino a 2 mesi usavo ChatGPT con le custom instructions) o Claude 2 di Antropic che per questo specifico task è molto buono. Il segreto è la velocità di decisione. Nel dubbio spesso scarto perché se l’articolo è veramente meritevole è segnalato più volte e, anche se sbaglio, lo recupero grazie ad altre segnalazioni della community. Sotto questo punto di vista la numerosità delle segnalazioni dello specifico approfondimento entra nel mio processo decisionale.

Il risultato della decisione è poi abbastanza semplice:

Scarto l’approfondimento perché non è adatto alla newsletter e può capitare anche a tante “cose” interessanti ma che non ritengo utili nel nostro contesto.

Entra nella “Hall of Fame” cioè è grandioso e quindi ne parlo nella newsletter e viene inserito in apposita area di Airtable. Per gli amanti dei numeri :-) ho circa 35 articoli classificati così dall’inizio della newsletter.

Entra nel “Pianificatore Google Sheet della Newsletter” e quindi potenzialmente nella newsletter

Fase 2 - Generazione dei contenuti

Se la fase 1 è distribuita temporalmente e mi capita, per esempio, di usare anche il tempo in cui sono in coda al supermercato, la fase 2 è una fase ben specifica e concentrata in slot puntuali.

Ma cominciamo a descrivere cosa è il mio “Pianificatore Google Sheet della Newsletter” che è una parte fondamentale del processo di realizzazione de “LaCulturaDelDato”. Dal punto concreto è un semplice Google Sheet (l’excel della suite Google), raggiungibile con click da ogni mio device, dove faccio una pianificazione a circa 3 o 4 mesi degli argomenti delle puntate. Ogni riga è un numero della newsletter e ci sono due colonne per ciascuna delle cinque aree della newsletter. Nella prima colonna conservo l’argomento che voglio discutere (massimo 5 parole es: “Giornalismo e AI”) e nella colonna a fianco raggruppo tutti i link di approfondimento di quell’argomento che inserisco a valle del processo decisionale. In questo modo quando ritengo un articolo di valore lo posiziono in un argomento già creato (insieme agli altri approfondimenti) o creo un nuovo argomento. Una volta a settimana decido i 5 argomenti (uno per sezione es: data science, investimenti ecc) per il nuovo numero della newsletter che vado a creare. La scrittura di ciascuna delle cinque parti della newsletter avviene in questo modo: la sera dedico 30 minuti all’argomento di cui voglio scrivere il pezzo per la newsletter nella sera successiva. In questi 30 minuti leggo e seleziono i contributi presenti nella cella del pianificatore Google Sheet. Durante il giorno successivo rifletto sull’argomento e su quanto letto e la sera scrivo in circa 15 minuti il pezzo per la newsletter e dedico invece i 30 minuti successivi per l’argomento del giorno successivo. Durante la scrittura ma sempre più anche durante la lettura mi avvalgo di un ChatGPTs che mi sono costruito sull’esperienza del primo anno (è un insieme di custom instructions) di newsletter. Si chiama, per gli onomastici :-), “DataMuse AI” e fa fondamentalmente 4 macro attività:

Mi aiuta nelle traduzioni

Mi corregge typos e lavora sulla scorrevolezza secondo mie specifiche linee guida

Mette in discussione quello che scrivo suggerendomi punti di vista o approfondimenti diversi

Mi suggerisce tre titoli su cui poi scelgo e lavoro per ogni sezione della newsletter

Ovviamente in maniera iterativa e (spesso) migliorativa lavoro sul “DataMuse AI”perché si adatti alle mie esigenze e alle nuove attività che man mano automatizzo

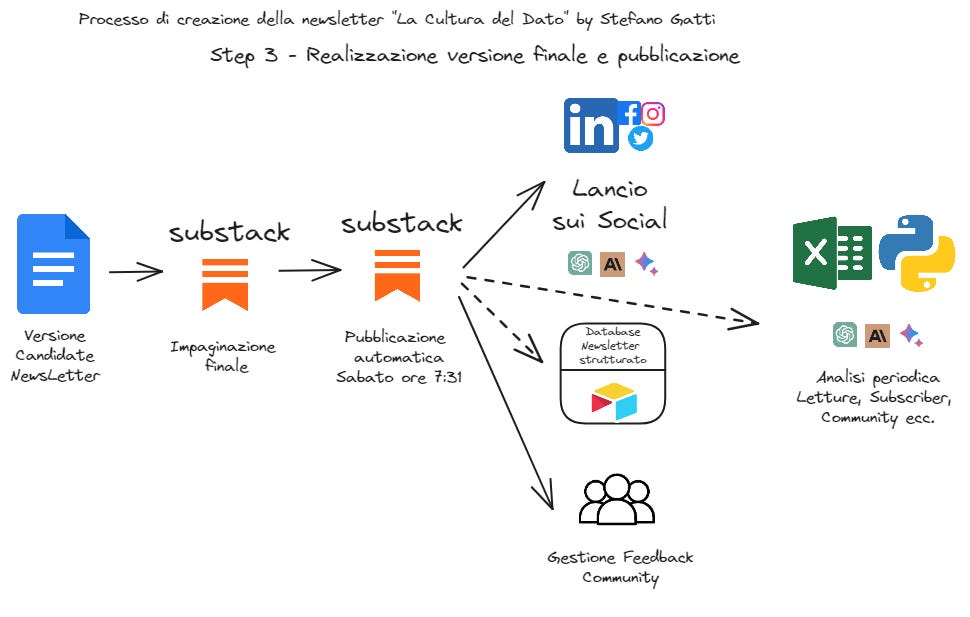

Fase 3- Generazione dei contenuti

La terza parte è quella tutto sommato più semplice e la sto cercando di automatizzare in queste ultime settimane per dare più tempo possibile a quella che è l’attività più di valore in questa fase e cioè la relazione che ho con voi lettori e che ho esemplificato nella figura sopra definendola “Gestione Feedback Community”. In realtà è la parte che è cresciuta di più nel tempo e che mi ha sorpreso in positivo. E’ sicuramente uno dei motivi che stanno facendo proseguire questa esperienza fino “almeno” a questo numero 100!

Dal momento che l’ho fatta già troppo lunga ora spazio alle domande che mi avete fatto e a cui non ho risposto ancora su come faccio e quanto dedico a realizzare la newsletter.

Quanto tempo prima è pronta ogni newsletter dalla sua emissione, per essere sicuro che impegni imprevisti non impatti o la data di pubblicazione?

Una settimana prima è su substack già pianificata per invio. Mi tengo una settimana per imprevisti, peraltro settimana ad oggi mai usata. Quindi sono circa 1 settimana in anticipo, arrivo a 2 durante l’estate.

Quanto tempo ci metti a settimana?

E’ difficile dirlo perché ci sono approfondimenti che hanno fatto parte o fanno parte del mio lavoro. Ma diciamo a scriverla e pubblicarla circa tra le 4 e le 5 ore a settimana. Il tutto molto distribuito in slot che cerco di mantenere ad alta focalizzazione: circa 45 minuti l’uno che trovo spesso la sera tra le 21 e le 22.30 e nel week-end.

Come riesci ad organizzarti con tutte le informazioni che ricevi e averne traccia di quello che scrivi? Spesso fai riferimento a numeri passati ...

Uso in primis Airtable dove ho strutturato diciamo lo scheletro di tutte le newsletter pubblicate con link e persone che cito negli articoli. Questo mi aiuta molto a ricordare …

Mi piacerebbe sapere come fai per documentarti in maniera così approfondita e per testare i vari strumenti e librerie?

Essendo un pessimo e troppo saltuario programmatore uso in primis Google Colab come ambiente di test o Anaconda se voglio testare qualcosa di meno standard in locale e poi con l’avvento di ChatGPT-4 faccio scrivere a lui molta parte del codice. Sono un pessimo e saltuario ma talmente “vecchio” programmatore, analista e tester da avere esperienza a sufficienza per capire il codice e usando la modalità test-driven capire quando sbaglia … ChatGPT-4!

🙏Thanks To …

Innanzitutto a tutti voi lettori che dai 249 della prima puntata siete diventati 3200. Grazie per gli stimoli, per i consigli e anche per tutti i complimenti che mi avete fatto. Se sono arrivato alle puntata 100 è anche grazie a voi e soprattutto perchè, come ho scritto nei ringraziamenti del libro “La Cultura del Dato”:

“Scrivere per me è un viaggio.

Nel passato, nel presente e nel futuro.

Nel passato perché mi consente di metabolizzare le esperienze fatte, esorcizza la paura di perderle e fornisce ulteriore valore ad esse nel presente e nel futuro.

Nel presente perché lo arricchisce e mi consente di capirlo meglio.

Nel futuro perché mi aiuta a provare a ipotizzare scenari e mitigare le ansie del futuro che ci aspetta.”

Poi devo ringraziare, in ordine rigorosamente cronologico di presenza, gli ospiti intervistati nelle puntate dispari:

, Andrea Guzzo, Christian Racca, , , , Michele Barbera, Cervellin, Luca Massaron, , , , , , Serena Bonaretti, Irene Finocchi, Paolo Ferragina, , , , Eric Enge, , Eugenia Anello , , , Antonio Specchia, .Infine alcune persone speciali che sono state molto importanti in questo viaggio di 100 tappe:

- con cui ho costruito le fondamenta.

- con cui ho scritto gli ultimi due libri e non solo.

Mia moglie Federica Scarrione che è stata soppiantata da ChatGpt4 come correttore di bozze ma che mi fornisce sempre preziosi e validi consigli.

I miei figli, che non vogliono essere citati esplicitamente per questioni di privacy (non esistono più i giovani di una volta 🙂) e che numeri alla mano mi ricordano sempre di non prendermi troppo sul serio!

Se hai ulteriori suggerimenti e riflessioni sui temi di questo numero o per migliorare questa newsletter scrivimi (st.gatti@gmail.com) o commenta su substack.

Se ti è piaciuta e non sei ancora iscritto lascia la tua mail qui sotto e aiutami a diffonderla!

Alla prossima!

Ho tenuto questa puntata da parte per leggerla con calma. Prima di tutto, è un piacere scoprire che anche tu sei un devoto di Douglas Adams. Secondo.... beh, complimenti, competenza, tecnica, passione in una newsletter/cocktail che neanche il Daiquiri quello fatto come si deve. Infine vorrei chiedere quanto tempo impieghi per l'aggiornamento, oltre a quello implicito nella preparazione della newsletter. Non ce la farò mai comunque ad avere la tua competenza, ma almeno mi misuro ☺️

Grazie 100 volte per questa newsletter che ci ha aiutato ad affrontare in modo analitico e senza pregiudizi il mondo dell'AI.

E grazie per aver condiviso i tuoi processi di raccolta e condivisione della conoscenza.